Cuando la crisis del coronavirus empezó a extenderse por el planeta, la Organización Mundial de la Salud (OMS) alertó de que «no estamos luchando únicamente contra una epidemia; estamos luchando contra una infodemia». Avisó de la que «las noticias falsas se propagan con más rapidez y facilidad que el propio virus, y son igual de peligrosas».1 [OMS, Conferencia de Seguridad de Múnich, 15 de febrero de 2020, https://www.who.int/es/dg/speeches/detail/munich-security-conference]

En respuesta a esta crisis, el presidente de Facebook, Mark Zuckerberg así como otros directivos de la empresa lanzaron una campaña mediática para publicitar los esfuerzos adicionales de su compañía por frenar la propagación de bulos relacionados con la COVID-19. Facebook anunció que dichos esfuerzos habían sido «rápidos», «contundentes» y se habían ejecutado «bastante bien».2 [Entrevista de CBS a Sheryl Sandberg: Facebook is removing fake coronavirus news "quickly", COO Sheryl Sandberg says, Comunicado de Facebook: Combating COVID-19 Misinformation Across Our Apps, Nota de Prensa de Mark Zuckerberg – 18 de marzo, https://about.fb.com/wp-content/uploads/2020/03/March-18-2020-Press-Call-Transcript.pdf]

El pasado mes de febrero, nuestro equipo empezó a detectar y a rastrear la desinformación rampante que rodea a la COVID-19 en la red. En marzo, nuestro equipo de investigación pasó a analizar y evaluar la eficacia de los esfuerzos que Facebook ha puesto en marcha para combatir esta infodemia en su plataforma principal.

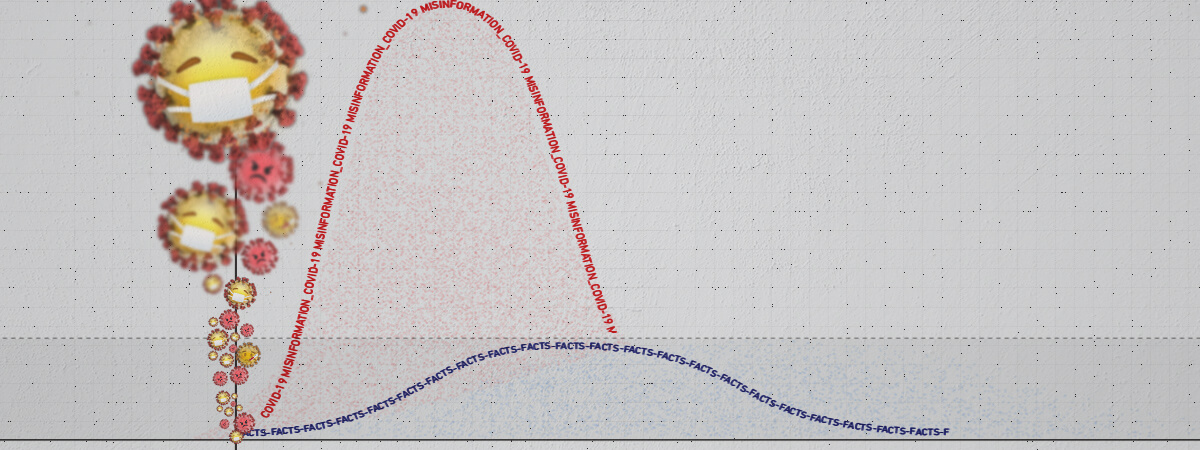

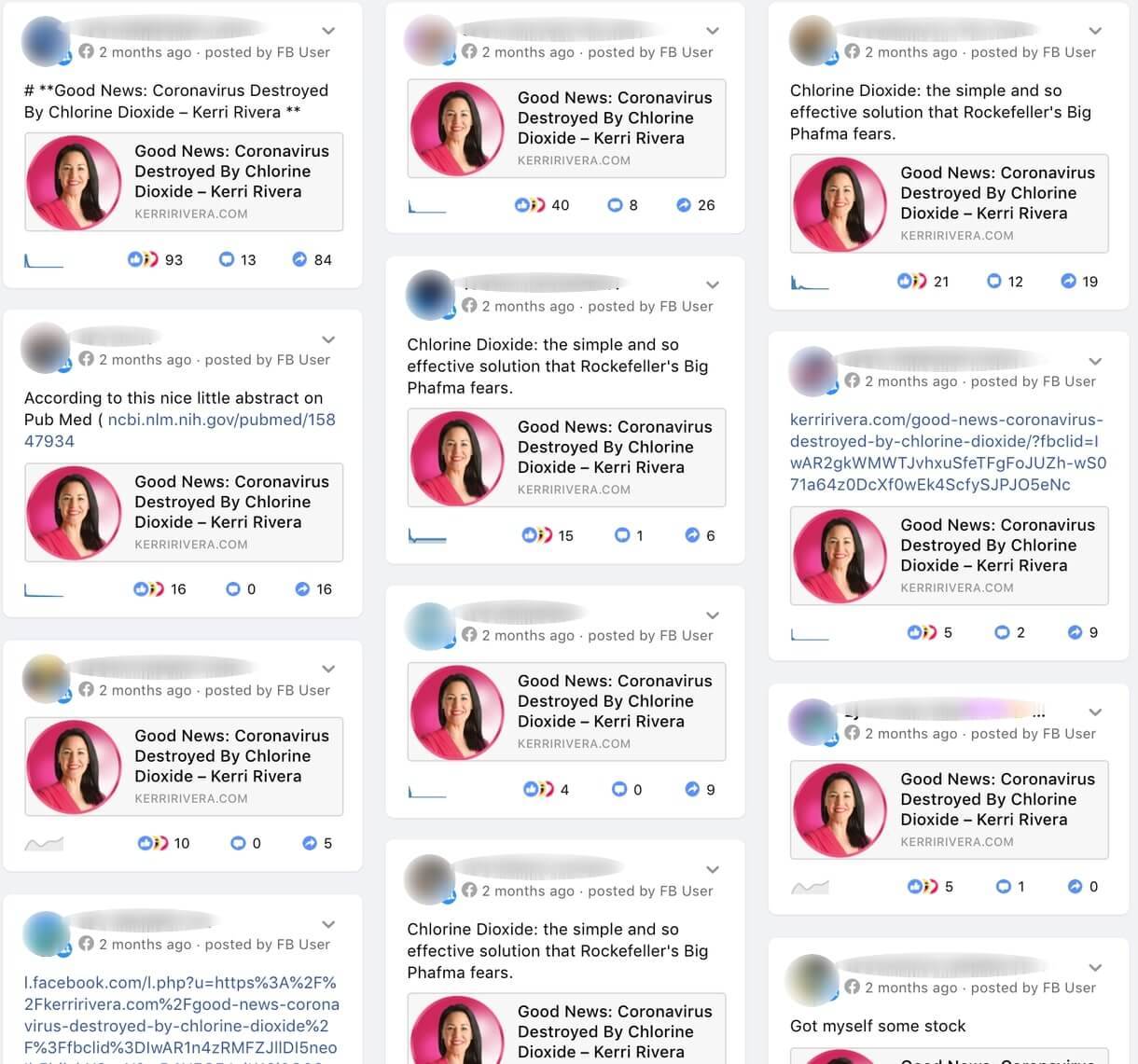

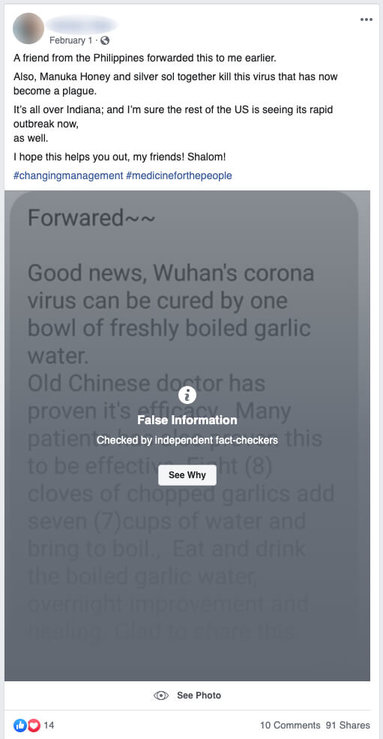

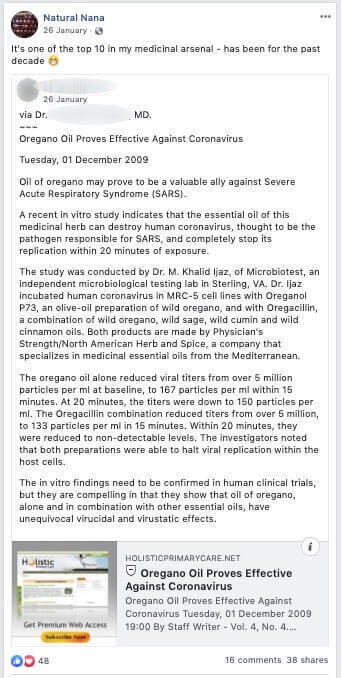

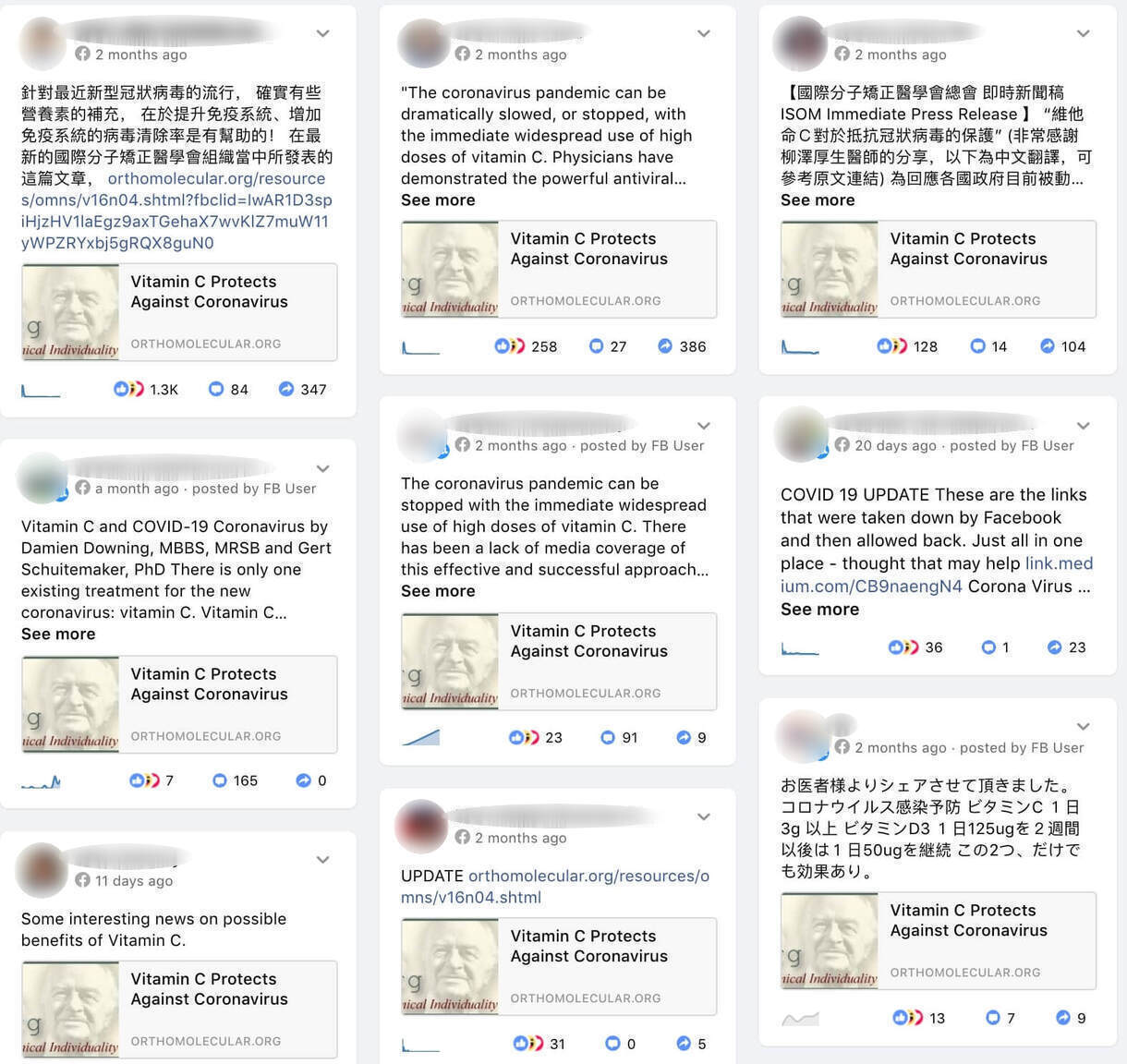

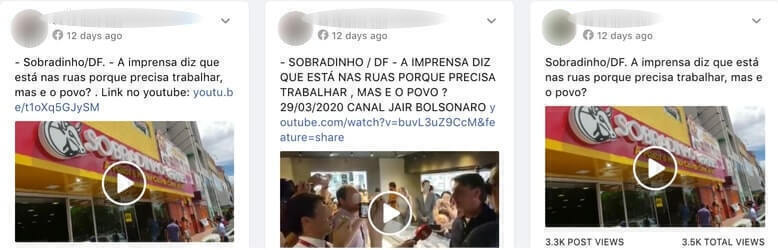

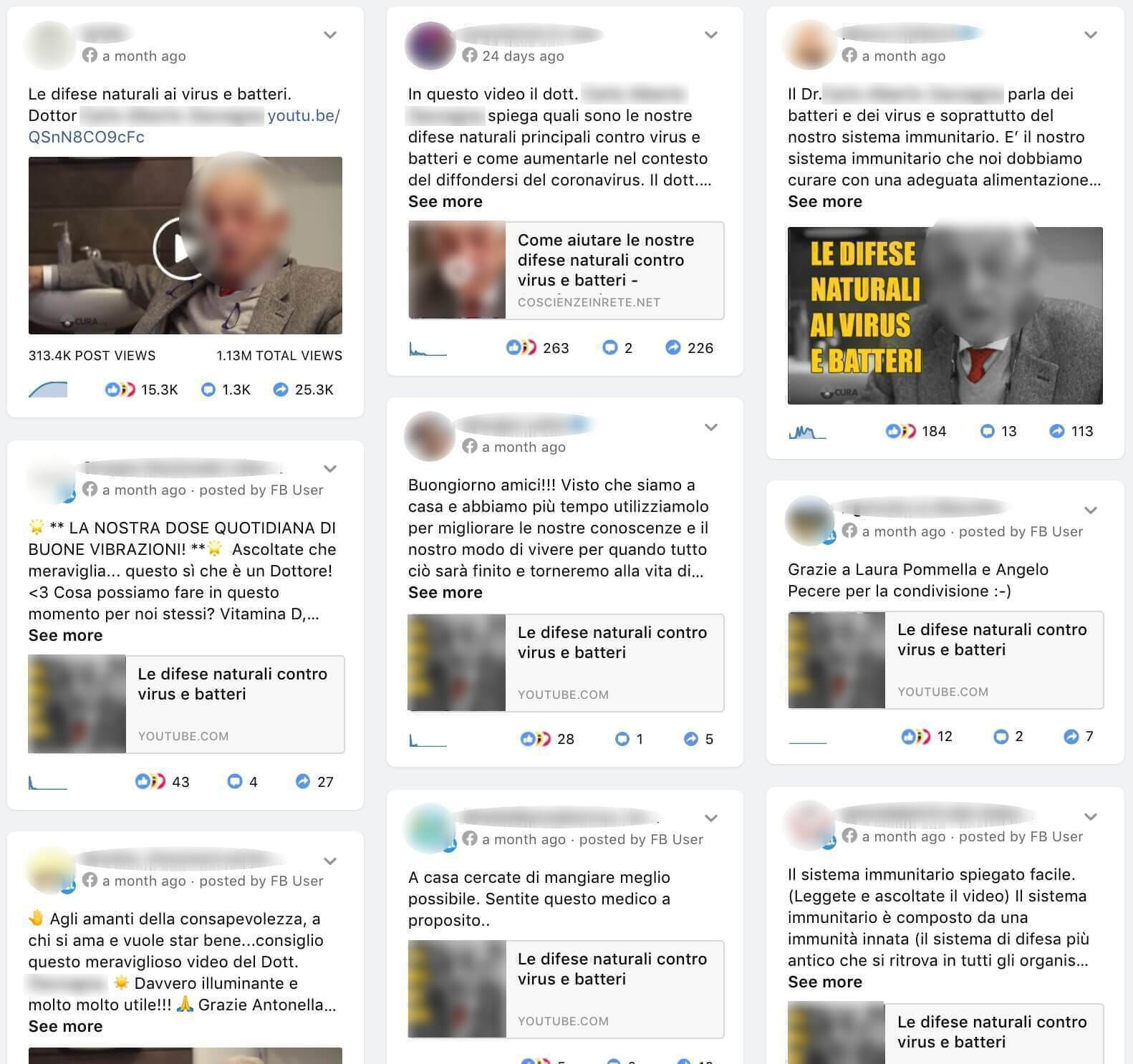

Para este estudio, de los miles de bulos relacionados con el coronavirus que han circulado por Facebook, decidimos examinar, en seis idiomas distintos, más de un centenar de bulos sobre el virus clasificados como falsos y engañosos y causantes potenciales de daños al público por parte de verificadores independientes.3 [Para más detalle, véase el apartado de Metodología y conjunto de datos.]

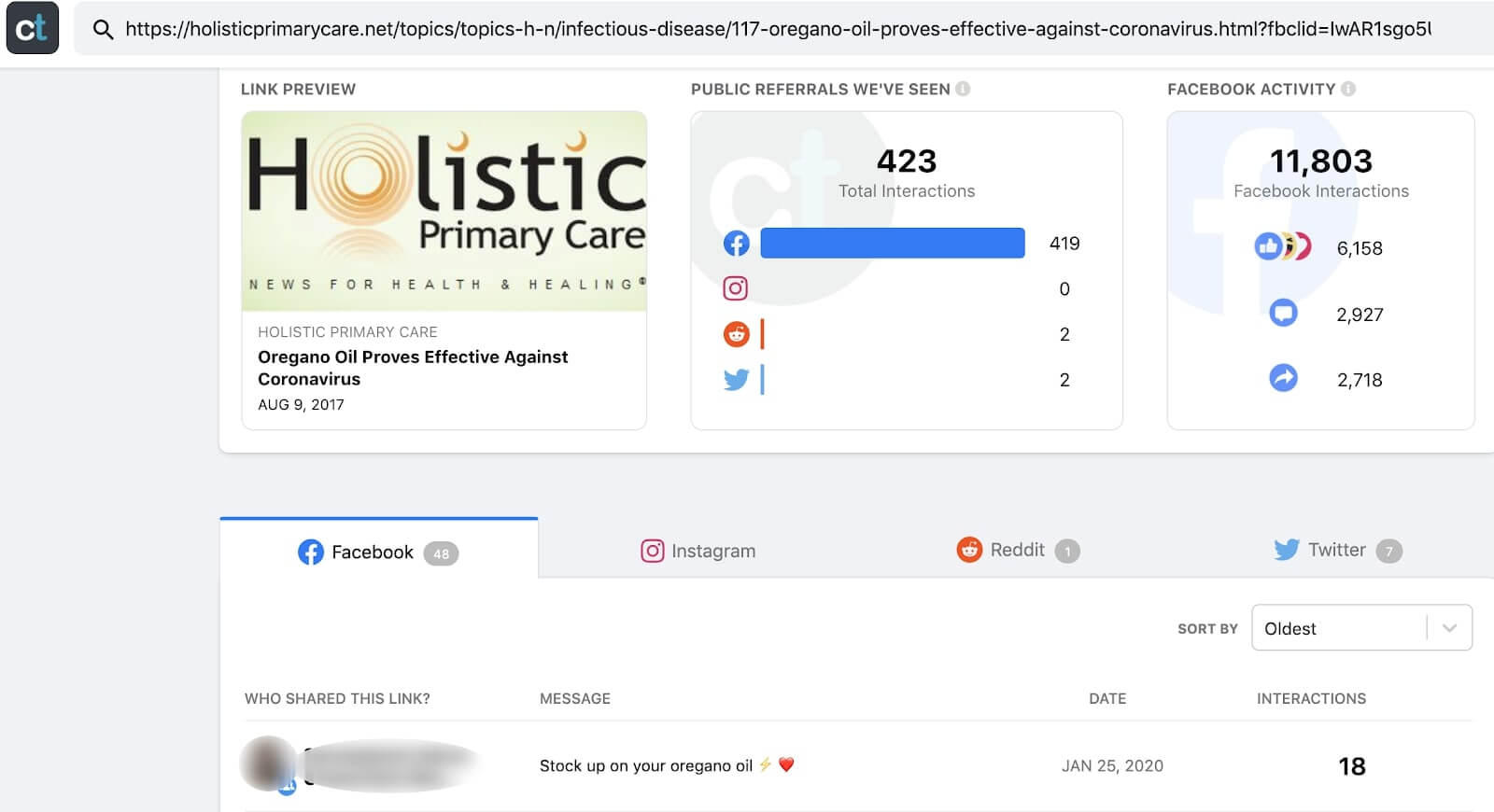

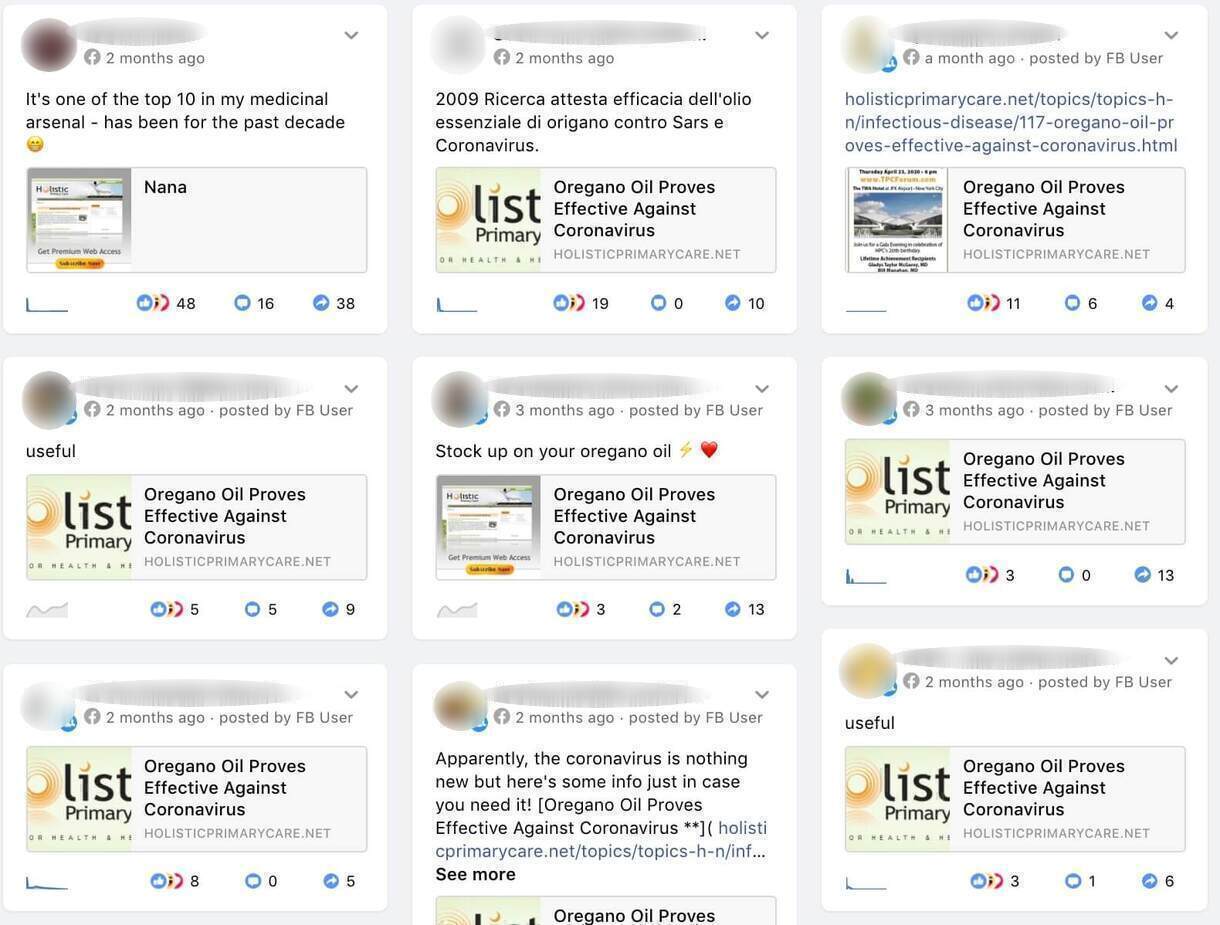

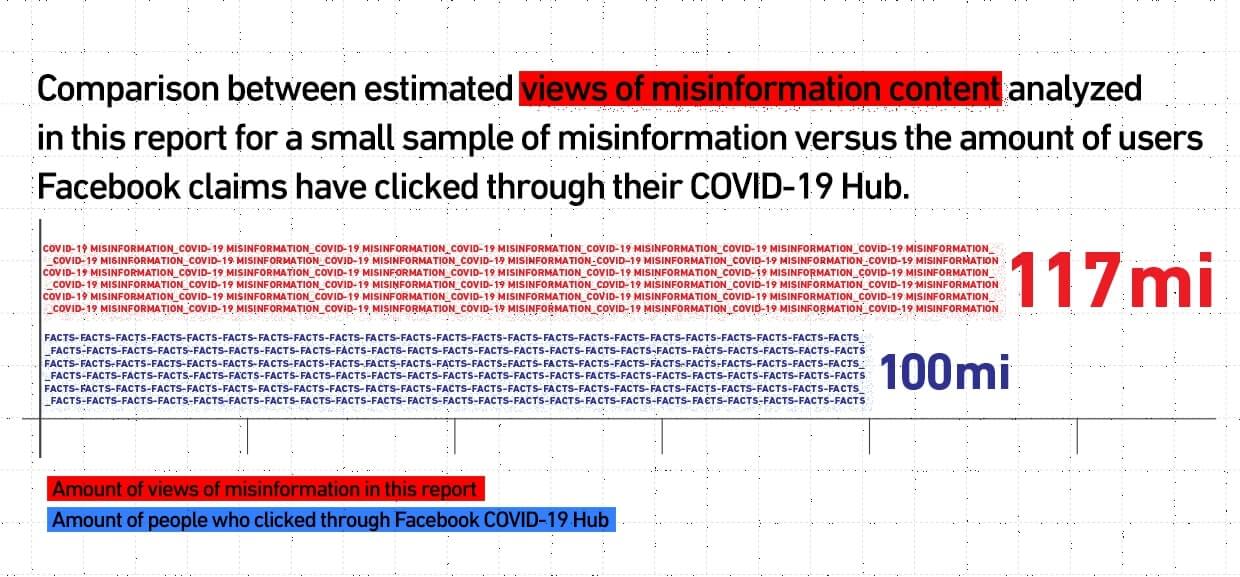

Así, descubrimos que hay millones de usuarios de la plataforma que continúan expuestos a los peligros del consumo de información falsa y perniciosa sobre el coronavirus a gran escala. Calculamos que la muestra de contenido que seleccionamos y analizamos se compartió más de 1,7 millones de veces en Facebook y recibió unos 117 millones de visualizaciones estimadas; y esto no es más que la punta del iceberg desinformativo.

Aunque apreciamos la labor encomiable del equipo anti-desinformación de Facebook para combatir esta infodemia, las políticas actuales de la red social han sido insuficientes a la hora de proteger a sus usuarios.

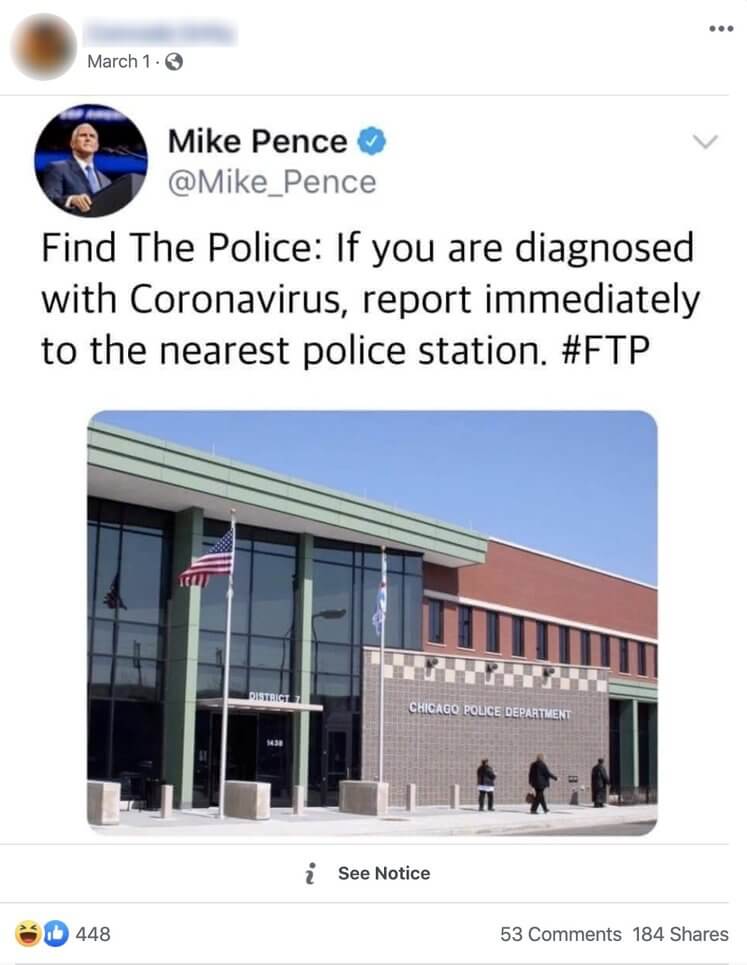

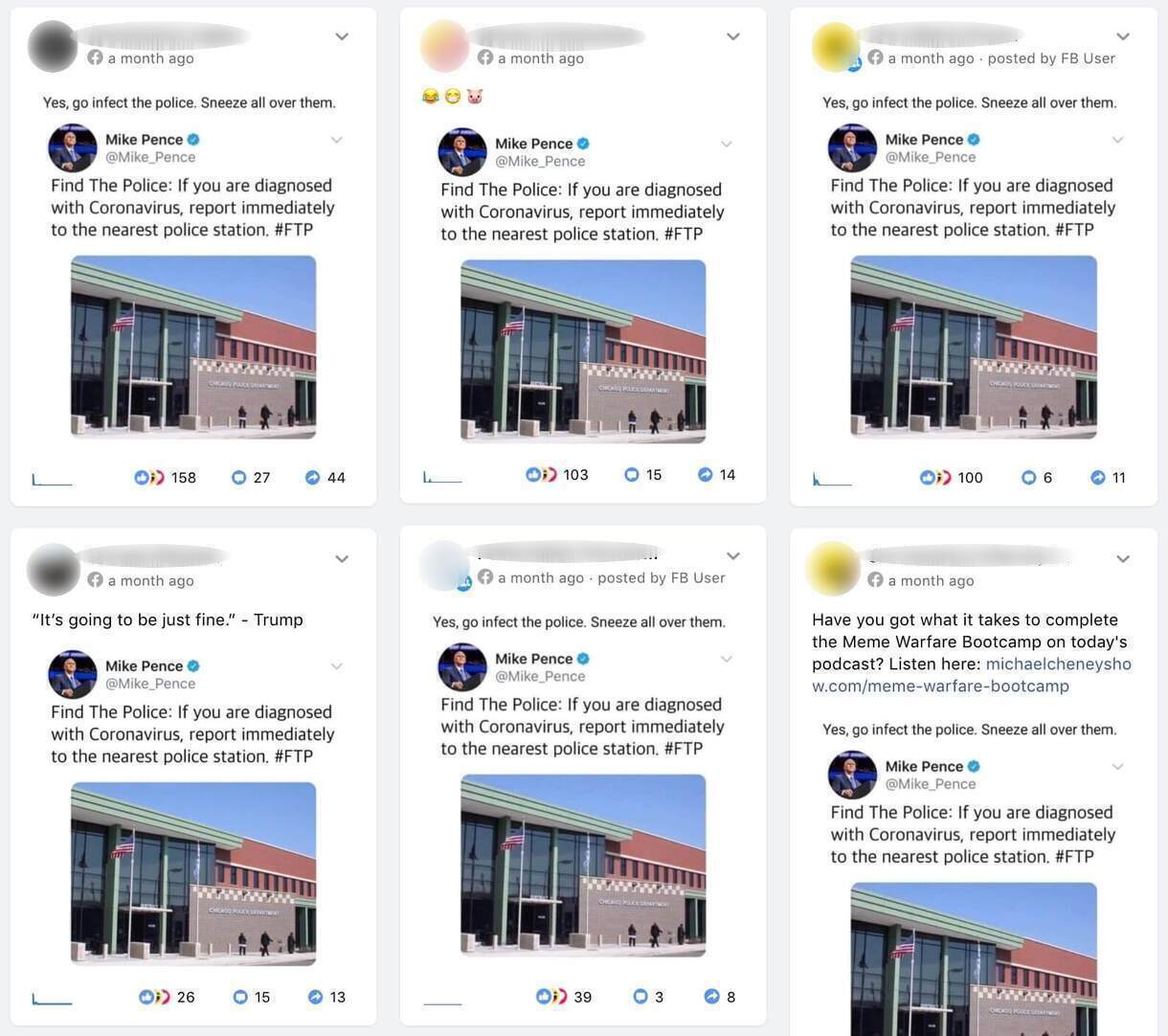

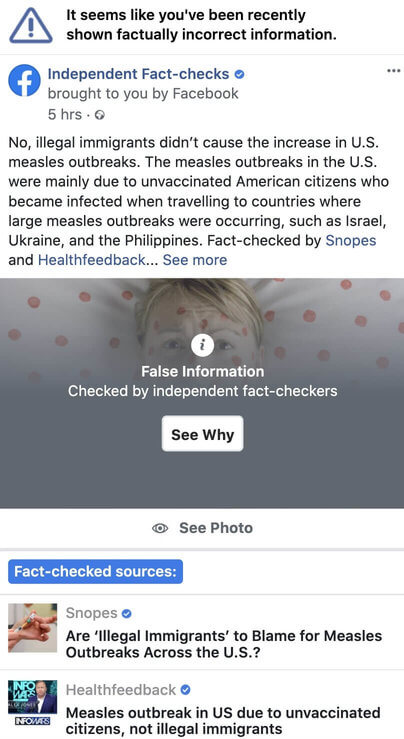

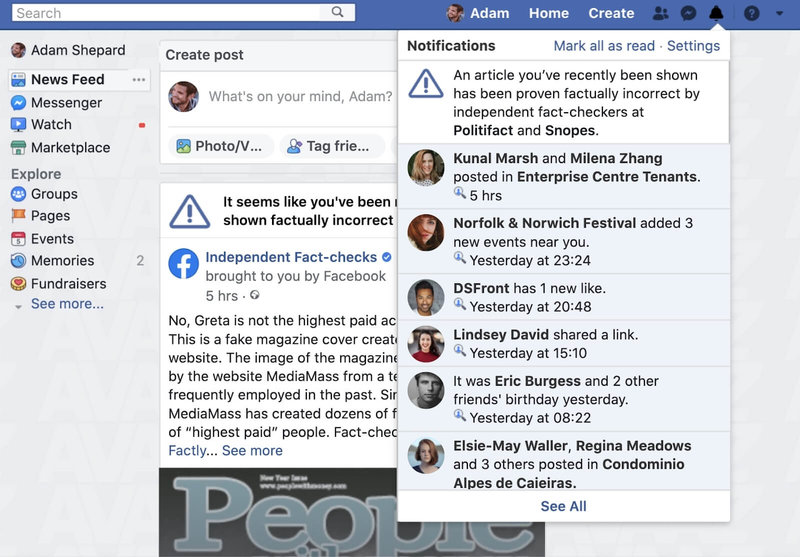

Del 41% de los bulos que siguen en Facebook sin etiquetas que alerten de su contenido falso, el 65% ha sido desmentido por los socios del propio programa de verificación de la plataforma4 [Para nuestro estudio, solo analizamos contenido desinformativo que contaba o bien con una verificación primaria o con una directa – es decir, con verificaciones que enlazaban o se referían a publicaciones o artículos específicos. Para aquel contenido que carecía de verificación primaria o directa, aplicamos resultados de verificación primaria a afirmaciones relacionadas con la salud idénticas a las que figuraban en esas publicaciones.]. Durante el tiempo que duró nuestra investigación5 [Nuestro período de investigación abarca las acciones y declaraciones de Facebook entre el 16 de enero de 2020 y el 14 de abril de 2020. Sin embargo, a raíz de las conversaciones con los representantes de la plataforma, nos sentimos alentados por los esfuerzos que la red social está realizando para mejorar sus políticas y procesos según algunas de las recomendaciones que se mencionan en este informe.], el contenido permaneció en la red social pese a que la compañía había prometido publicar «advertencias serias» que alertaran contra la desinformación señalada por verificadores de datos y otros organismos externos, y retirar todos los bulos susceptibles de causar un daño físico inminente.6 [Facebook, Combating COVID-19 Misinformation Across Our Apps, 25 de marzo de 2020, https://about.fb.com/news/2020/03/combating-covid-19-misinformation/]

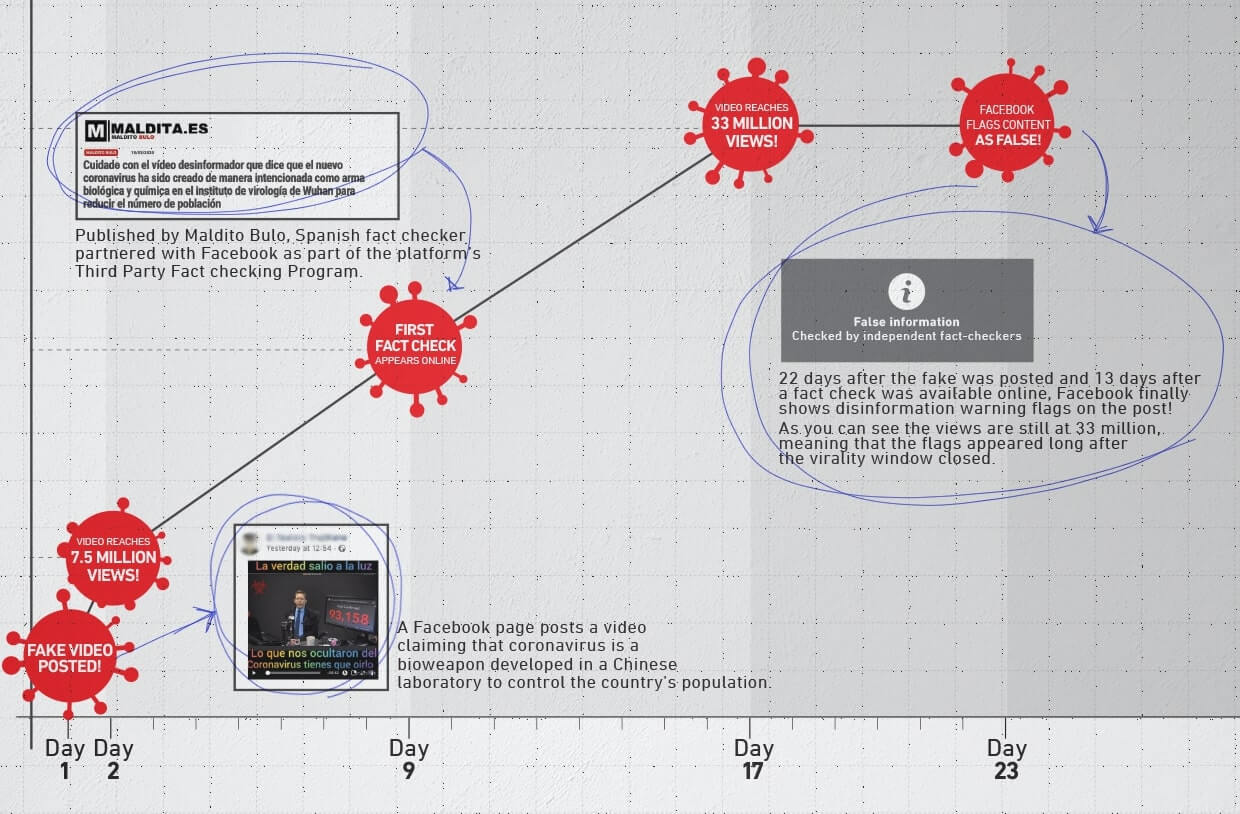

En segundo lugar, Avaaz ha constatado que Facebook tarda un tiempo significativo en aplicar sus medidas contra la desinformación. Estos retrasos son especialmente preocupantes puesto que permiten a millones de usuarios acceder a contenido desinformativo sobre el coronavirus antes de que la plataforma verifique su veracidad y lo etiquete a través de una advertencia o lo retire. En esta misma línea, descubrimos que la plataforma puede llegar a tardar hasta 22 días en degradar dicho contenido y en publicar etiquetas que notifiquen que se trata de un bulo, lo que deja un margen de tiempo muy amplio para que se viralice.

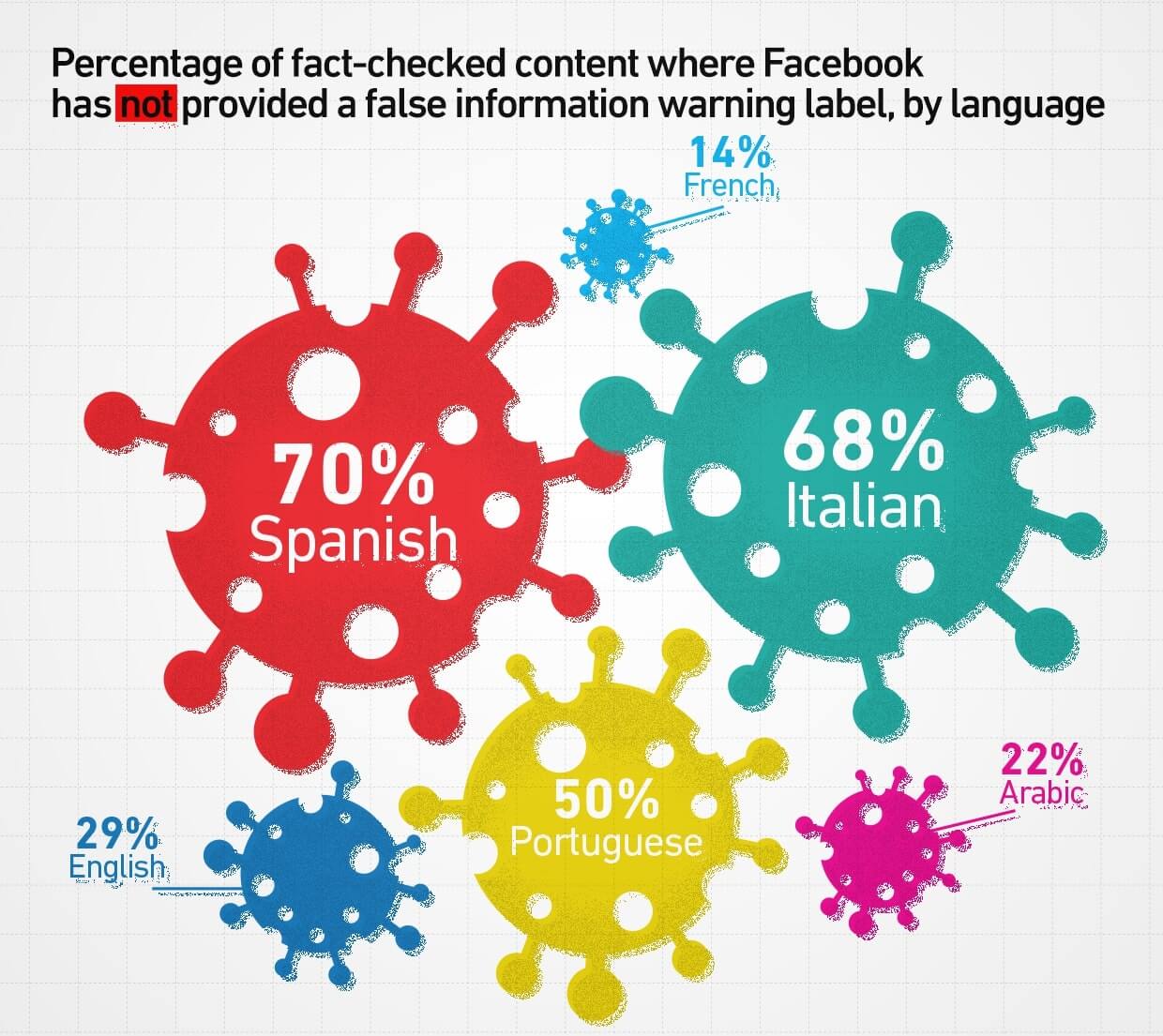

Nuestro análisis indica, asimismo, que los usuarios italohablantes e hispanohablantes podrían ser más vulnerables a la exposición a los bulos. Facebook aún no ha emitido etiquetas de advertencia en un 68% y un 70% del contenido examinado en italiano y en español respectivamente, frente al 29% en el caso del inglés.

La magnitud de esta infodemia combinada con la reticencia de Facebook a notificar de forma retroactiva y enviar rectificaciones a todos y cada uno de los usuarios que hayan estado expuestos a bulos perniciosos sobre el coronavirus socava los esfuerzos por «frenar la curva» en todo el mundo y podría, potencialmente, suponer un peligro para muchas vidas.

Tras una conversación con los miembros del equipo anti-desinformaicón de Facebook que tuvo lugar el 13 de abril de 2020, celebramos el compromiso sin precedentes de la red social de instaurar alertas con carácter retroactivo para luchar contra la desinformación sobre el coronavirus, lo que supone un primer paso tan importante como necesario que podría llegar a salvar vidas7 [Con este gesto para con las personas expuestas a la desinformación, Facebook se desmarca del resto de las principales plataformas sociales en cuanto a informar a sus usuarios sobre el contenido falso con el que han podido toparse y supone un primer paso para solventar las fallas en sus políticas que se han destacado más arriba.].

Con el fin de asegurar una retirada rápida de la plataforma del contenido susceptible de causar un daño físico inminente a los usuarios de Facebook, el 8 de abril de 2020 remitimos a la empresa una lista de publicaciones falsas que, a nuestro parecer, incumplían sus políticas, con la recomendación de que las retiraran. Por su parte, a 14 de abril de 2020, Facebook ha retirado 17 de las publicaciones de ese listado, que sumaban unos 2,4 millones de visualizaciones estimadas.

Cuéntaselo a tus amigos