ESTUDO: "MOSTRAR OS FATOS"

UM ANTÍDOTO CONTRA A DESINFORMAÇÃO

16 de abril de 2020

Voltar ao Hub da Desinformação

UM ANTÍDOTO CONTRA A DESINFORMAÇÃO

16 de abril de 2020

Voltar ao Hub da Desinformação

Um novo estudo acadêmico prova que fornecer correções feitas por verificadores de fatos aos usuários de redes sociais que viram informações falsas ou enganosas, pode diminuir a crença na desinformação1 [Para fins de simplificação, neste relatório usamos "desinformação" e "notícias falsas" de forma intercambiável para nos referirmos a informações falsas ou enganosas verificáveis, que têm o potencial de causar danos ao público, por exemplo, comprometendo a democracia ou a saúde pública.] em média de 50%, podendo chegar a 61%.

Essas reduções significativas, e empiricamente comprovadas, na crença em informações falsas oferecem uma solução imediata de como plataformas e legisladores podem proteger os usuários das redes sociais contra a crescente ameaça da desinformação online: por meio do princípio de “Mostrar os Fatos”.

Esta pesquisa2 [Nota: este relatório apresenta as conclusões da pesquisa conduzida por Dr. Wood e Dr. Porter. O estudo acadêmico em si será publicado independentemente pelos autores.], encomendada pela Avaaz, foi conduzida pelo Dr. Ethan Porter, da George Washington University, e pelo Dr. Tom Wood, da Ohio State University, referências no estudo de correções de informações falsas.

Para testar a eficácia das correções, um um modelo hiper-realista do Facebook foi criado para simular a experiência do usuário na plataforma. Uma amostra representativa da população estadunidense, composta por 2 mil participantes anônimos, foi escolhida e entrevistada de forma independente pela Equipe de Pesquisa Acadêmica, Política e de Assuntos Públicos da empresa global de dados e pesquisa de opinião YouGov. Esses usuários foram expostos aleatoriamente a até 5 notícias falsas baseadas em exemplos reais de conteúdo falso ou enganoso compartilhado no Facebook e posteriormente verificado de maneira independente.

Através de um modelo aleatório, alguns dos usuários receberam correções após verem as notícias falsas e outros usuários viram apenas o conteúdo falso ou enganoso. Um terceiro grupo não foi exposto nem às notícias falsas e nem às correções. Em seguida, os participantes da pesquisa responderam a perguntas para testar se eles acreditavam ou não nas notícias falsas a que foram expostos.

Além da conclusão de que as correções podem cortar a crença de usuários estadunidenses em conteúdos de desinformação pela metade, o estudo também aponta que:

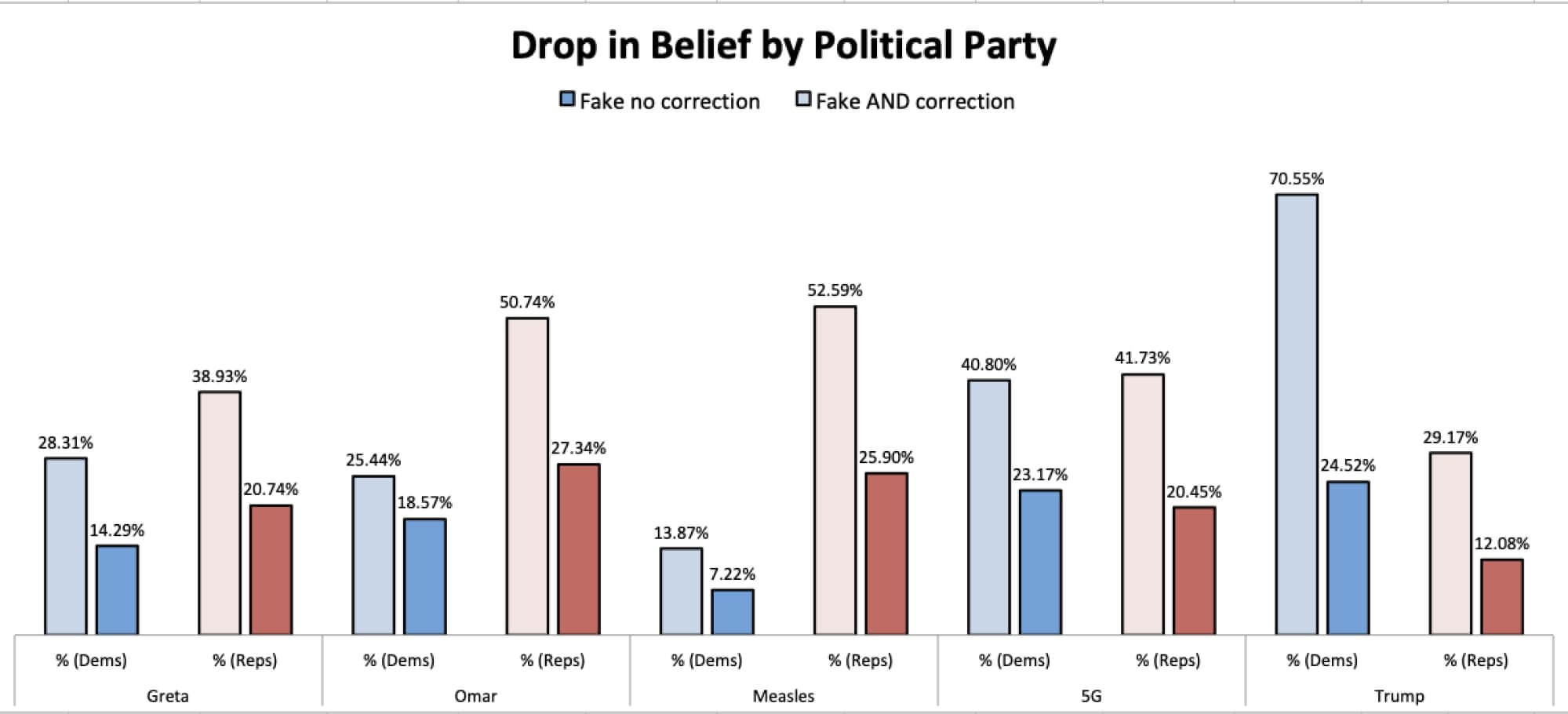

A redução média na crença em informações falsas ou enganosas após serem expostos a uma correção foi de 50% para republicanos e 47% para democratas.

61,5% dos participantes deixaram de acreditar em uma notícia falsa a qual afirmava que o presidente Trump disse que os republicanos são o grupo de eleitores mais estúpido do país.

50,7% dos participantes deixaram de acreditar em uma notícia falsa que alegava que os surtos de sarampo foram causados por imigrantes ilegais após serem expostos a uma correção em comparação àqueles que viram apenas a notícia falsa.

50% dos participantes deixaram de acreditar em uma notícia falsa que alegava que Greta Thunberg é a ativista mais bem paga do mundo e que ganhou milhões com seu ativismo.

42,4% dos participantes deixaram de acreditar em uma notícia falsa que alegava que a foto de uma soldado da Somália que circulava nas redes sociais mostrava a deputada estadunidense Ilhan Omar em um campo de treinamento terrorista na Somália.

42% dos participantes deixaram de acreditar em uma notícia falsa que alegava que a instalação de torres 5G requer a utilização de roupas de proteção contra a radiação.

De 1.000 estadunidenses que participaram do estudo, 68,4% concorda ou concorda plenamente que o Facebook deve informar os usuários quando estes forem alvo de desinformação e deve fornecer correções redigidas por verificadores de fatos independentes.

60,8% concorda ou concorda plenamente que as empresas de redes sociais devem ser obrigadas por lei a protegerem seus usuários contra a desinformação, com apenas 18,1% discordando dessa proposta.

Atualmente, a desinformação ameaça democracias e vidas ao redor do mundo. Nos Estados Unidos, estudos indicam que os eleitores estadunidenses enfrentam uma crescente ameaça de desinformação, com o objetivo de semear desconfiança e polarização na corrida para as eleições de 2020. Os usuários das plataformas de redes sociais em todo o mundo estão sendo alvo de informações falsas sobre o novo coronavírus, causando pânico e dificultando ainda mais o trabalho dos profissionais de saúde que buscam conter a doença. Empresas e consumidores estão enfrentando perdas financeiras devido às campanhas online de difamação e desinformação que abalam o mercado.

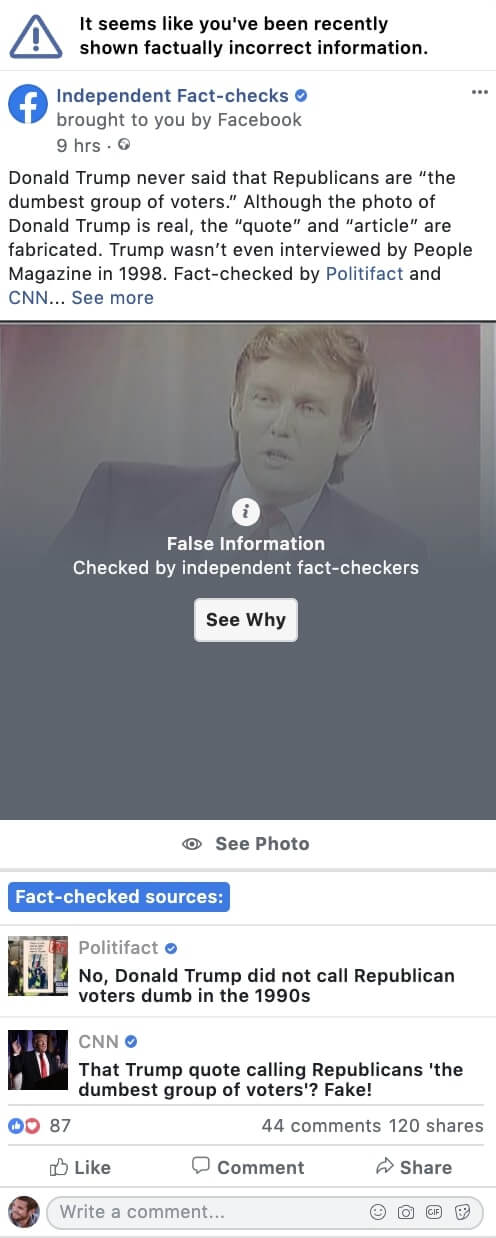

Até agora, o Facebook e outras plataformas de redes sociais tomaram medidas mínimas e insuficientes para a verificação de fatos, e ainda não estão fornecendo correções retroativas a todos os usuários que viram ou interagiram com um conteúdo falso ou enganoso. Como detalha o relatório a seguir, essa pesquisa indica que as plataformas de redes sociais devem aumentar consideravelmente esses esforços. Esse relatório demonstra que “Mostrar os Fatos", ou seja, alertar e fornecer correções feitas por verificadores de fatos independentes a todos os usuários que viram ou interagiram com informações verificáveis falsas ou enganosas é uma das defesas mais eficazes contra campanhas coordenadas de desinformação e mentiras que se tornam virais.

As plataformas devem demonstrar sua seriedade em relação ao problema da desinformação online, implementando o mais rápido possível a solução proposta no estudo. Os governos também devem agir para legislar sobre a desinformação e garantir que o princípio de "Mostrar os Fatos" seja aplicado a conteúdos enganosos e prejudiciais, que podem enfraquecer democracias e colocar vidas em risco.

A dramática ascensão da desinformação deixam legisladores consternados, pois se encontram em um dilema entre a proteção da democracia e o compromisso com a liberdade de expressão. Os legisladores podem estar paralisados, mas atores mal-intencionados continuam explorando a desinformação para enfraquecer o discurso democrático. A Avaaz divulgou recentemente relatórios documentando conteúdos falsos que tinham como objetivo influenciar as eleições dos EUA em 2020, e que atingiram 158 milhões de visualizações. Uma outra pesquisa sobre a campanha de desinformação antivacina apontou que 57% dos brasileiros que não vacinaram seus filhos mencionaram motivos que são, na verdade, factualmente imprecisos segundo a Organização Mundial da Saúde.

Por meio de investigação, advocacy e pesquisa, a Avaaz procurou não apenas destacar a escala da ameaça, mas também fornecer aos executivos das plataformas e aos legisladores em todo o mundo soluções eficazes para conter a "infodemia" de desinformação que está soterrando milhões de usuários de redes sociais.

A pesquisa inicial da Avaaz, assim como nosso diálogo com especialistas sobre o assunto em diferentes países, nos deixou claro que oferecer correções sofisticadas a usuários que são alvo de informações falsas reduziria significativamente o impacto da desinformação e ajudaria a criar resiliência a esse fenômeno. No entanto, as plataformas inicialmente se recusaram a aplicar essa solução na escala necessária e fizeram lobby contra essa proposta junto aos legisladores. O argumento era que não havia pesquisas suficientes mostrando que as correções funcionam no ambiente das redes sociais. Além disso, as plataformas frequentemente recusam acesso aos seus próprios dados e pesquisas internas a respeito desse tópico.

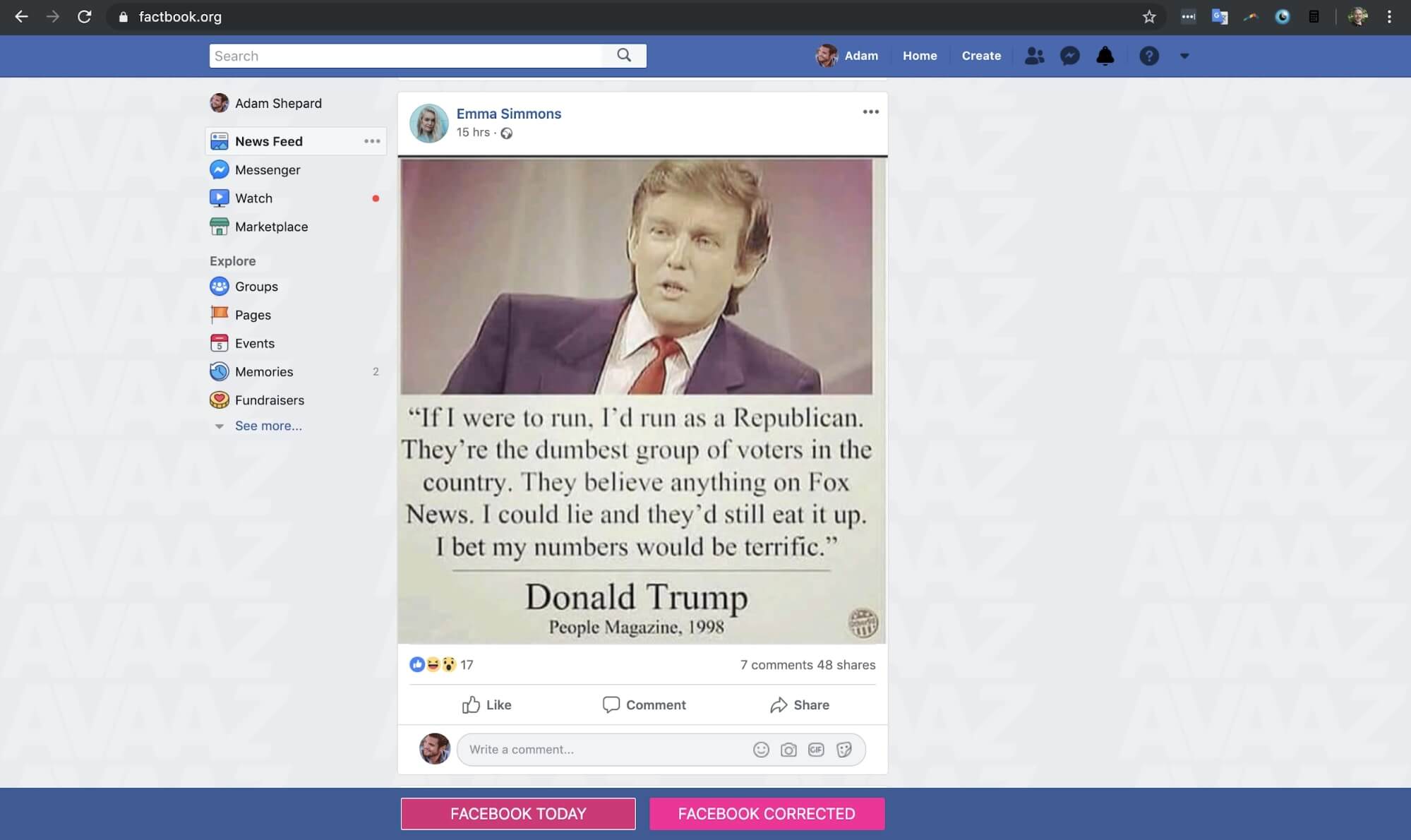

Para testar se a alegação, agora refutada, de que as correções retroativas não eram eficazes no contexto das redes sociais, a Avaaz projetou uma plataforma que se assemelhava bastante à interface do Facebook. Começamos a testar internamente designs diferentes de como as correções poderiam ser aplicadas a usuários de todo o mundo. Nossos resultados iniciais se mostraram promissores e nos permitiram aprimorar uma proposta altamente eficiente para as correções.

No entanto, para garantir a integridade e independência dessas descobertas, e para que elas pudessem ser replicadas em um ambiente anônimo, compartilhamos nossos resultados com especialistas acadêmicos da área, interessados em realizar um estudo independente com foco na população dos EUA.

Pesquisadores de ponta nessa área, Dr. Ethan Porter, da George Washington University, e Dr. Tom Wood, da Ohio State University, conduziram esse estudo acadêmico.

Para testar o princípio de "Mostrar os Fatos", a Avaaz criou o primeiro modelo hiper-realista do Facebook, e os pesquisadores usaram a plataforma de pesquisa padrão da YouGov para testar 2 mil participantes anônimos que foram expostos a até 5 notícias falsas. A distribuição de postagens falsas ou enganosas foi aleatória: alguns usuários receberam correções, alguns viram apenas as notícias falsas e outros não expostos a notícias falsas e nem as correções. Eles então responderam a perguntas para testar se eles acreditavam nas informações falsas.

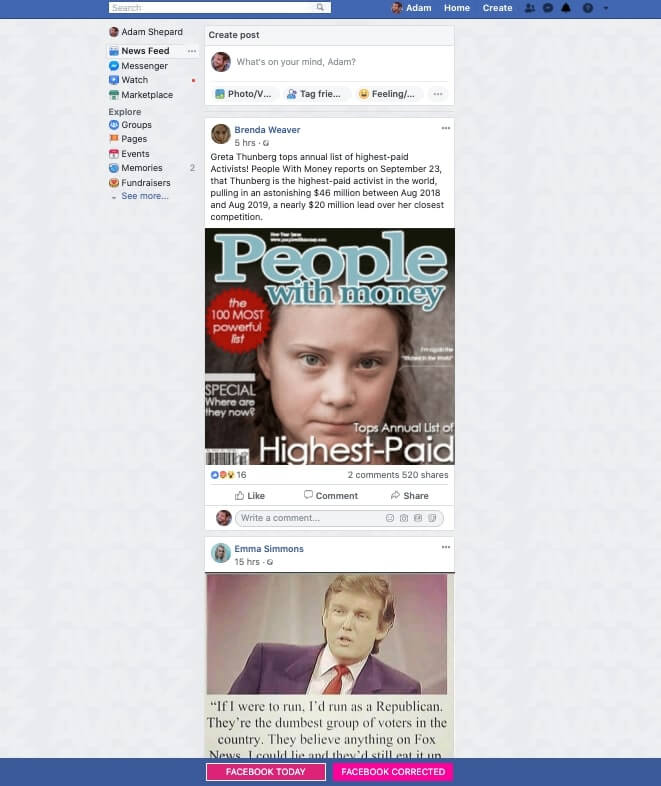

Figura 1: modelo hiper-realista da interface do Facebook para testar correções (visite Factbook.org para saber mais).

Os resultados do estudo são definitivos: em média, “Mostrar os Fatos” reduz pela metade a crença na desinformação (49,4%). As correções também funcionaram em relação a conteúdo partidário: o melhor resultado, 61%, foi em relação a uma citação forjada atribuída ao presidente Donald Trump, na qual ele afirmava que "os republicanos são estúpidos". O mais relevante é que as correções funcionam em usuários de diversas filiações partidárias e ideologias políticas. A redução média na crença na desinformação após ver uma correção foi de 50% para republicanos, 47% para democratas, 40% para liberais e 57% para conservadores.

Os resultados finais reforçam ainda mais a conclusão de que as plataformas de redes sociais podem reduzir pela metade os efeitos e a crença na desinformação ao aplicarem “Mostrar os Fatos”, mostrando a todos os usuários expostos à desinformação as correções efetuadas por verificadores de fatos independentes.

Dada a urgência das futuras eleições nos Estados Unidos e em todo o mundo, e das várias crises sanitárias que podem causar danos em grande escala, "Mostrar os Fatos" é atualmente uma das mais fortes defesas que temos contra as campanhas coordenadas de desinformação que ameaçam as nossas democracias.

Além do mais, essa solução é popular: 87% das pessoas na Alemanha, França, Espanha e Itália, 74% no Reino Unido e 68% nos EUA apoiam essa proposta amplamente. A maioria delas -- (76% ou mais dos cidadãos da Alemanha, França, Espanha e Itália, 77% dos cidadãos do Reino Unido e 61% dos cidadãos EUA) acredita que precisamos de regulamentação para garantir que ela seja colocada em prática.

"Mostrar os Fatos" requer que as plataformas distribuam as correções efetuadas por verificadores de fatos independentes a todas as pessoas expostas à desinformação.

Por exemplo:

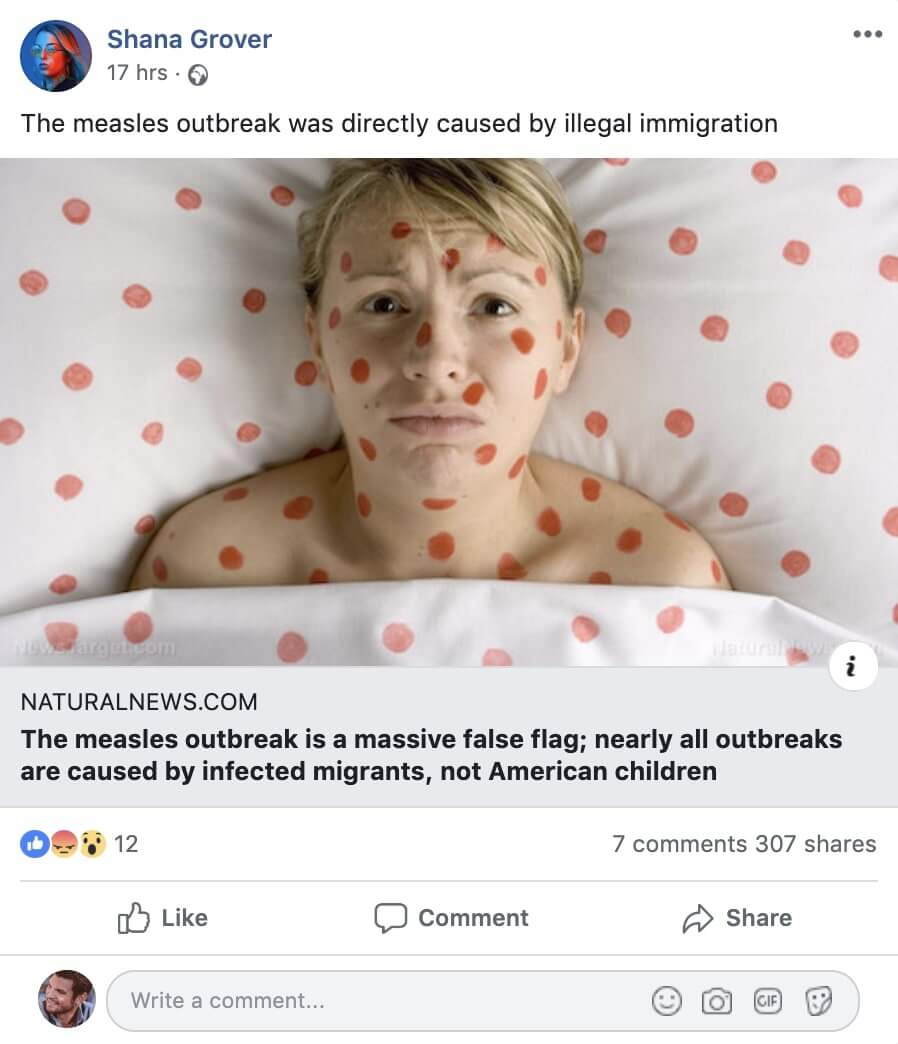

Todos os que leram, compartilharam, comentaram, curtiram ou interagiram de qualquer forma com essas postagens...

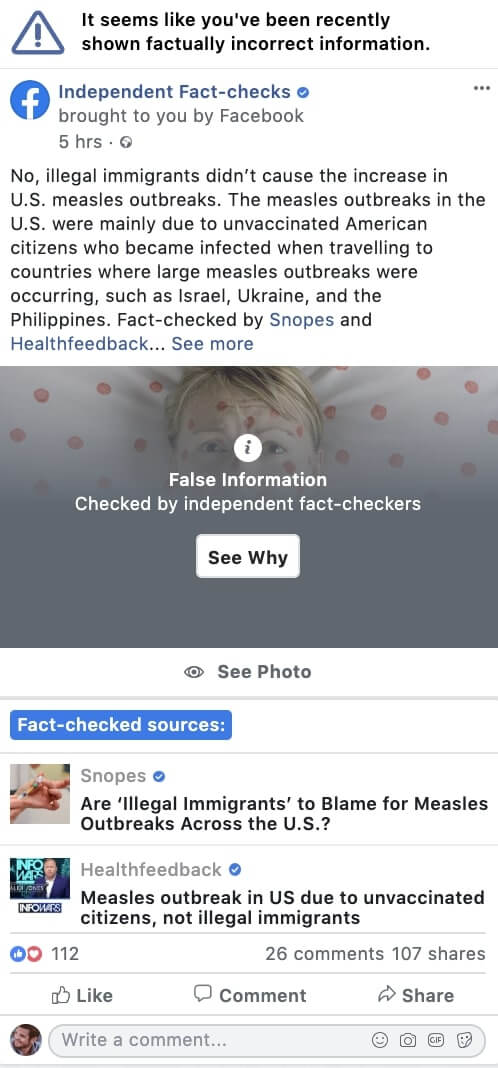

...também veriam algo assim quando verificadores de fatos independentes confirmassem que o conteúdo é falso:

Esse estudo procurou analisar se a exibição de uma correção aos usuários que já haviam visto e lido anteriormente um conteúdo falso ou enganoso (antes dele ser rotulado como tal) diminuiria significativamente a crença nas notícias falsas.

Primeiramente, foram escolhidos cinco artigos diferentes de notícias falsas retirados de exemplos reais postados no Facebook e checados independentemente por verificadores de fatos. Esses artigos foram selecionados refletindo uma série de temas de desinformação que circulam nas redes sociais.

Depois, foram criadas correções para cada conteúdo falso ou enganoso, com base nas checagens fornecidas pelos verificadores de fatos independentes.

Os cinco itens foram:

Uma capa de revista manipulada, dizendo que Greta Thunberg é a ativista mais bem paga do mundo;

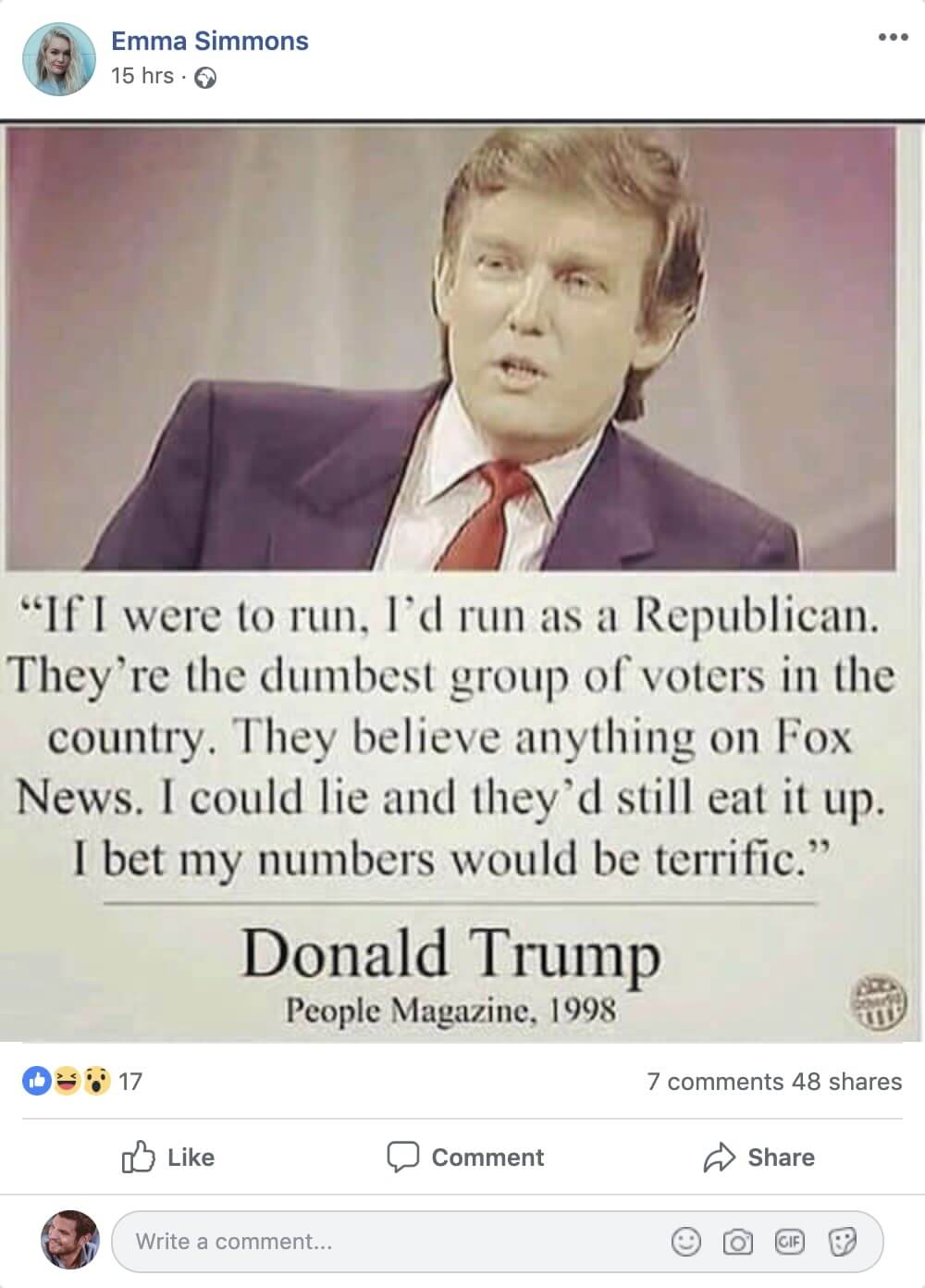

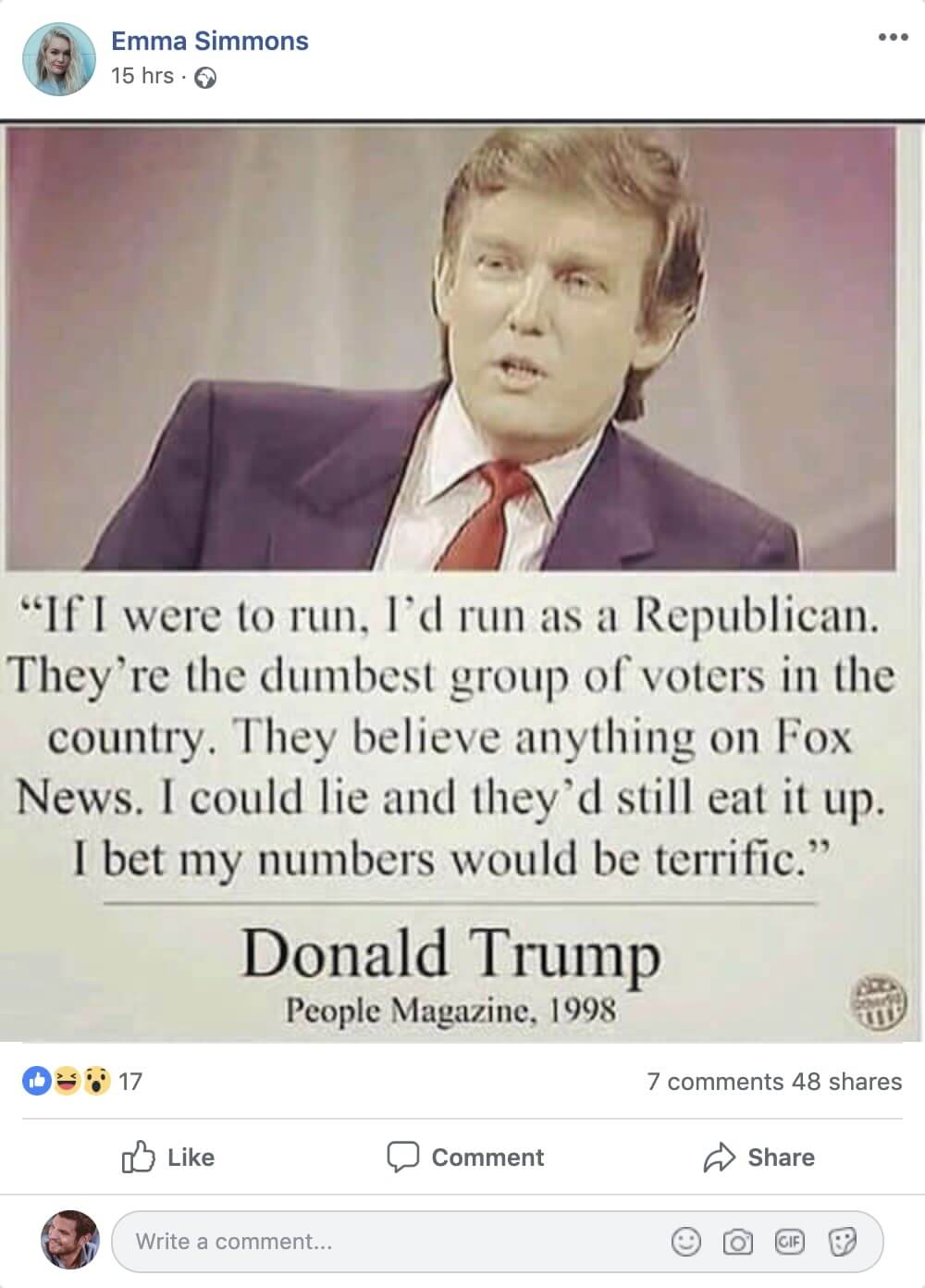

Um meme atribuindo falsamente a Donald Trump dizendo que “os republicanos são o grupo de eleitores mais estúpido” e que ele poderia conseguir seus votos;

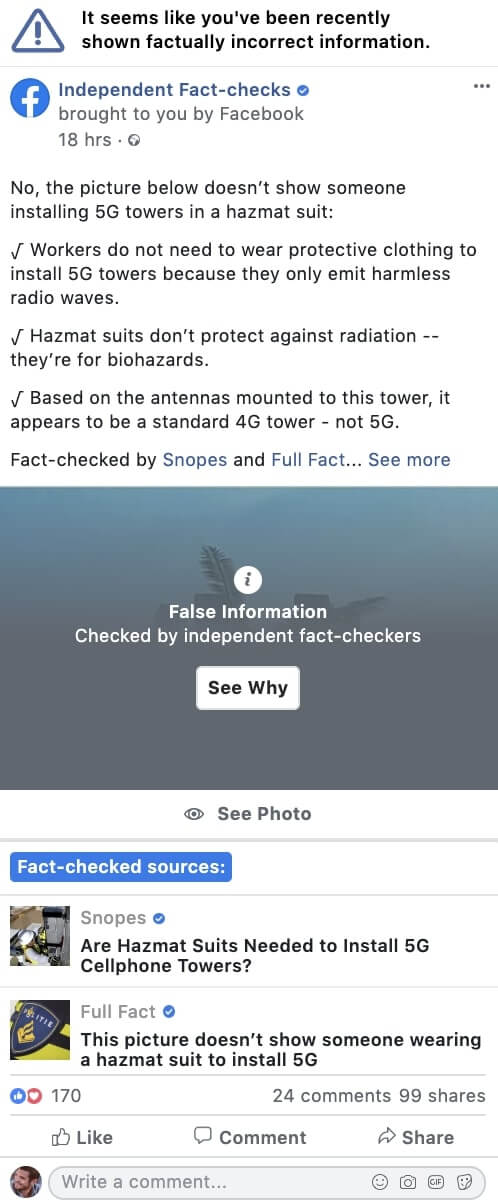

Uma foto antiga de uma mulher soldado das forças armadas da Somália com uma legenda deixando subentendido que se tratava da deputada Ilhan Omar em um campo de treinamento da Al Qaeda;

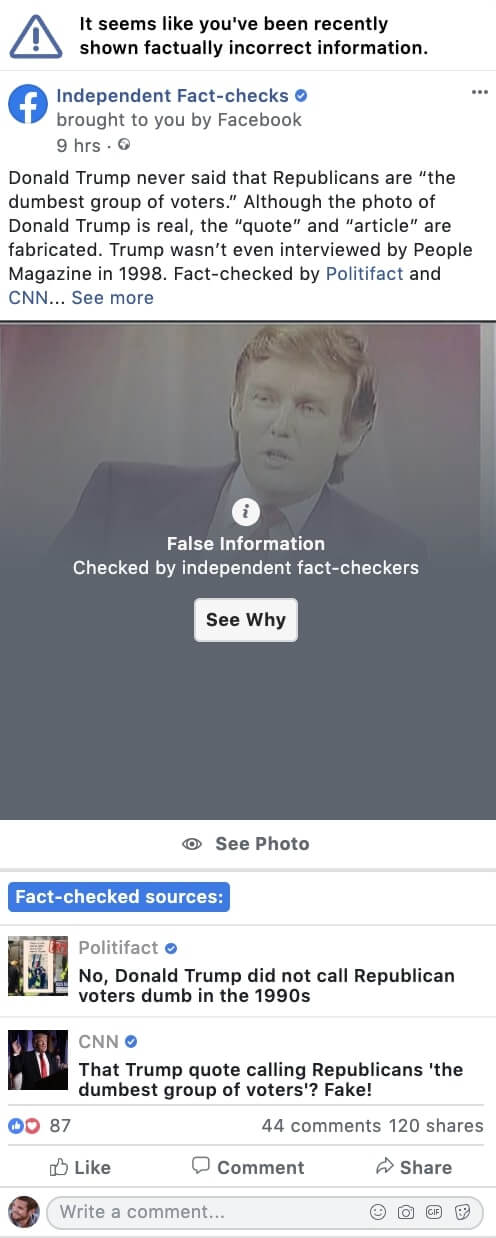

Um meme insinuando que a instalação de torres 5G é tão perigosa que os trabalhadores precisam usar roupas especiais de proteção contra a radiação;

Uma notícia falsa alegando que imigrantes ilegais foram responsáveis por surtos de sarampo nos EUA.

Na etapa seguinte, a Avaaz criou o Factbook.org, um site que imita fielmente a experiência do usuário no Facebook. Nele, preenchemos o feed de notícias apresentando uma mescla de conteúdo falso e enganoso, histórias verdadeiras e notícias reais, e conteúdo neutro (como fotos de cães e gatos). O conteúdo neutro que a Avaaz colocou no feed de notícias também foi retirado de postagens reais do Facebook e ligeiramente editado para garantir o anonimato de quem as postou originalmente.

O quarto passo foi garantir que os acadêmicos envolvidos na pesquisa pudessem testar o impacto das correções em uma amostra independente de cidadãos estadunidenses. Para isso, as ferramentas de pesquisa acadêmica da YouGov foram usadas (detalhes sobre os métodos de amostragem são fornecidos na seção de metodologia abaixo).

A maioria dos usuários veria as correções algum tempo após ter sido exposta ao conteúdo original falso ou enganoso. Para isso, dividimos o modelo em duas linhas do tempo. Na primeira, os participantes veriam notícias falsas (além de algumas postagens neutras, como fotos de comidas ou viagens). Na segunda, os participantes veriam as correções, assim como outras postagens neutras. Por fim, garantimos que o teste fosse totalmente aleatório. Especificamente:

Na primeira linha do tempo, os participantes viram entre zero e cinco itens falsos, além de três postagens neutras. O número de itens falsos, quais foram mostrados e a ordem em que foram mostrados foi completamente aleatória.

Na segunda linha do tempo, os participantes viram correções correspondentes aos itens falsos que viram na primeira linha do tempo, além de três postagens neutras diferentes. O número de correções foi novamente gerado aleatoriamente, de zero até o número total de itens falsos vistos na primeira linha do tempo.

Portanto, o desenho da pesquisa produziu, para cada pergunta do questionário, três grupos selecionados aleatoriamente:

Participantes que não viram nem o item falsonem a correção.

Participantes que viram o item falso, mas não a correção.

Participantes que viram tanto o item falso quanto a correção.

Em síntese, 2 mil participantes da pesquisa foram expostos de forma aleatória os seguintes cenários: a nenhum item; expostos apenas a notícias falsas (sem correções); expostos a notícias falsas e suas correções. Posteriormente, foi pedido a todos os usuários que respondessem a um questionário para que eles classificassem afirmações que diziam respeito às informações falsas ou enganosas.

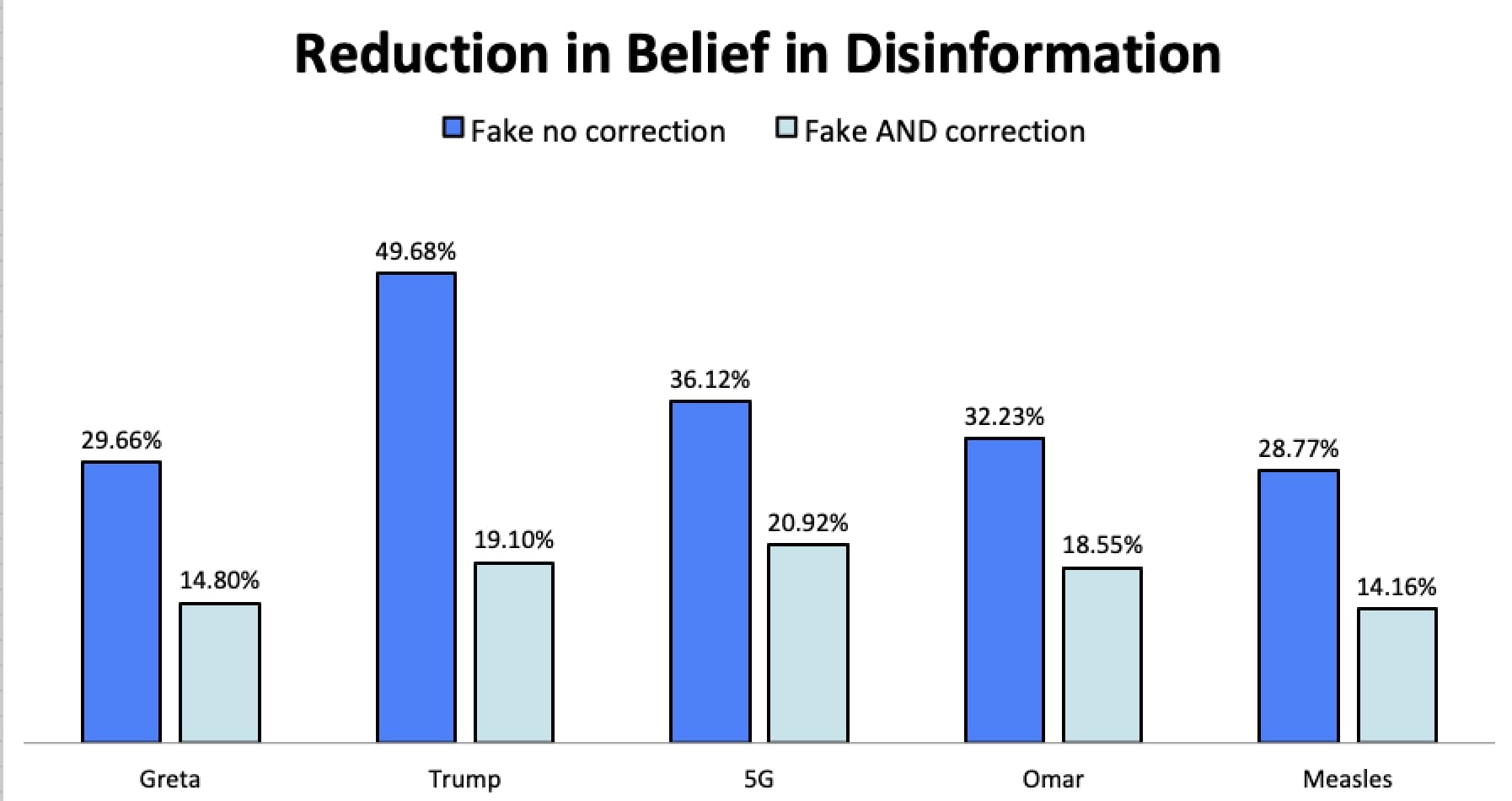

Os resultados do estudo são definitivos: em média, “Mostrar os Fatos” reduz pela metade a crença na desinformação (49,4%). As correções também funcionaram em relação a conteúdo partidário: o melhor resultado, 61%, foi em relação a uma citação forjada atribuída ao presidente Donald Trump, na qual ele afirmava que "os republicanos são estúpidos". O mais relevante é que as correções funcionam em usuários de diversas filiações partidárias e ideologias políticas. A redução média na crença na desinformação após ver uma correção foi de 50% para republicanos, 47% para democratas, 40% para liberais e 57% para conservadores.

Em azul escuro: porcentagem de pessoas que acreditaram na desinformação as quais foram expostas sem que vissem nenhuma correção.

Em azul claro: porcentagem de pessoas que acreditaram na desinformação as quais foram expostas depois de terem recebido um alerta de verificação de fatos.

Surpreendentemente, os efeitos continuaram fortes independentemente da filiação partidária ou ideologia.

Sarampo: após serem expostos a uma correção, 50,7% dos participantes deixaram de acreditar que os surtos de sarampo foram causados por imigrantes ilegais, em comparação com aqueles que viram apenas o item falso.

Greta: 50% dos participantes deixaram de acreditar que Greta é a ativista mais bem paga do mundo e que ganhou milhões com o seu ativismo.

Omar: 42,4% dos participantes deixaram de acreditar que a foto que circula nas redes sociais é da deputada norte-americana Ilhan Omar em um campo de treinamento terrorista na Somália.

5G: 42% dos participantes deixaram de acreditar que a instalação de torres 5G exige um traje especial de proteção contra radiação.

Trump: 61,5% dos participantes deixaram de acreditar que Trump chamou os republicanos de grupo de eleitores mais estúpido do país.

No geral, "Mostrar os Fatos" produziu uma redução de 49,4% na crença à desinformação.

A redução média na crença em notícias falsas depois de ver uma correção foi de:

Democratas: 47%

Republicanos: 50%

Liberais: 40%

Conservadores: 57%

Mais informações sobre cada notícia falsa e o detalhamento das respostas por partido e ideologia política podem ser encontrados no final do relatório, na seção "Resultados - Dados Detalhados".

Além da pesquisa principal, perguntamos para metade dos participantes (mil pessoas) duas questões adicionais. As respostas mostram que os estadunidenses apoiam amplamente “Mostrar os Fatos” e a criação de leis que exijam que as plataformas protejam os seus usuários contra a desinformação:

68,4% concorda ou concorda plenamente que o Facebook deve informar aos usuários quando eles forem alvo de informações falsas e enganosas, e que deve fornecer às pessoas expostas a esse conteúdo correções por parte de verificadores de fatos independentes;

60,8% concorda ou concorda plenamente que as empresas de redes sociais devem ser obrigadas por lei a proteger seus usuários contra a desinformação.

Após grande pressão por parte da Avaaz e de legisladores, o Facebook anunciou em outubro de 2019 que colocaria avisos mais evidentes nas postagens apontadas como desinformação por seus parceiros de verificação de fatos -- mas os avisos de conteúdo falso ou enganoso somente seriam exibidos para os usuários que vissem ou compartilhassem essa postagem depois de o conteúdo ter sido checado pelos verificadores de fatos.

No entanto, os passos adotados pelas plataformas, mencionados acima, estão longe de serem suficientes e atingem apenas uma porcentagem muito pequena dos usuários que são expostos à desinformação. Por exemplo, o modelo atual de correções aplicado pelo Facebook e pelo Instagram ignora a maioria dos usuários que são expostos a conteúdos falsos mal-intencionados antes da correção ser aplicada. A desinformação pode viralizar rapidamente, geralmente devido a um comportamento inautêntico coordenado3. Mas os verificadores de fatos independentes podem levar de dois dias a duas semanas para emitir uma correção, a partir da data em que a desinformação é sinalizada.

Consequentemente, o atual modelo de verificação de fatos usado pelo Facebook (modelo o qual é semelhante àquele testado pelo Twitter) alcança apenas uma pequena parcela dos usuários atingidos pela desinformação. Portanto, os esforços do Facebook, Instagram e Twitter de rotular as desinformações tardiamente, depois de verificadas, mas não notificar os usuários que interagiram com o conteúdo antes de ele ser sinalizado, são louváveis, mas não são o suficiente. Os resultados desse estudo mostram que o impacto de alertar e fornecer correções a todos os usuários que viram ou interagiram com a desinformação seria muito mais eficiente.

Por fim, embora uma redução de 50% na crença à desinformação seja significativa, ela deve ser vista como uma base para futuras otimizações das plataformas. O simples fato de implementar a proposta de "Mostrar os Fatos" oficialmente poderia aumentar ainda mais a sua eficácia. Durante os testes de experiência do usuário, mais da metade dos entrevistados indicou que não acreditava nas "correções" mostradas no Factbook desenhado pela Avaaz porque nunca tinha ouvido falar que o Facebook estivesse implementando correções oficialmente. Portanto, as correções em nosso design não pareciam autênticas para eles. Os usuários testados enfatizaram ainda que, se estivessem cientes que verificações de fatos independentes estavam sendo implementadas oficialmente, confiariam mais nelas.

Além disso, as plataformas possuem recursos significativos que as permitem melhorar continuamente o design das correções e os sistemas de notificação, para que sejam mais confiáveis, fáceis de compreender e serem lembradas.

Além disso, as plataformas possuem recursos significativos que as permitem melhorar continuamente o design das correções e os sistemas de notificação, para que sejam mais confiáveis, fáceis de compreender e serem lembradas.

O estudo da Avaaz dá continuidade a uma longa linha de pesquisas acadêmicas que mostram que correções eficazes podem reduzir, e até mesmo eliminar, os efeitos da desinformação. Em um estudo, de pesquisadores do MIT, eles concluíram que “[...] houve um grande deslocamento bipartidário na crença após a explicação [...] membros de todo o espectro político são capazes de mudar substancialmente suas crenças quando explicações não partidárias e contundentes são apresentadas."

Outro estudo da University of Michigan constatou que “[...]correções à desinformação são eficazes, mesmo diante de experiências emocionais e motivações partidárias.” Um terceiro grupo da City University of London, observou que “a crença na desinformação foi reduzida, em geral, pela metade com as correções, em comparação com um grupo de controle sem as correções [...]" e que os participantes tinham uma "boa lembrança geral da mensagem de correção".

Acreditamos que o Facebook sabe que "Mostrar os Fatos" funciona -- eles mesmos já implementaram correções para defender sua própria marca. Segundo uma reportagem da Bloomberg, que o Facebook não negou, a empresa rastreou informações falsas e enganosas sobre si mesma, criou correções e as enviou proativamente aos usuários. Para combater memes tóxicos, como aquele com o boato do “copiar e colar” em que os usuários eram incentivados a colar uma mensagem em seu status negando ao Facebook os direitos sobre os seus conteúdos, “a rede social tomou medidas ativas para eliminá-los. A equipe [do Facebook] criou mensagens desmentindo as afirmações e depois as apresentou a usuários que compartilharam o conteúdo, de acordo com documentos visualizados pela Bloomberg News e mais quatro pessoas familiarizadas com o assunto”. Nos EUA, o Facebook chegou a promover um post que desmentia o meme do “copiar e colar”.

Os pesquisadores estão confirmando que "Mostrar os Fatos" funciona. As plataformas de redes sociais sabem que as correções funcionam, usando frequentemente essa tática para proteger suas marcas. Por que, então, o Facebook, em particular, alertou sobre um possível efeito contrário?4 [Em Dezembro de 2017 o Facebook anunciou o seguinte: "as pesquisas acadêmicas sobre correção de informações erradas mostrou que colocar uma imagem forte como alerta ao lado de um artigo pode, na realidade, enraizar crenças já profundamente arraigadas, gerando um efeito contrário ao que buscamos."]

Esse argumento remonta a um estudo publicado em 2010 por Brendan Nyhan (University of Michigan) e Jason Reifler (Georgia State University). Esse documento aponta que um grupo de estudantes universitários, a quem foram mostradas correções desconstruindo notícias falsas sobre a presença de armas de destruição em massa no Iraque, passou a acreditar ainda mais fortemente que as armas de destruição em massa foram de fato encontradas (elas não foram). Esse estudo não foi realizado em um contexto de redes sociais ou usando uma plataforma que imitava um feed de notícias. Embora muitos tenham tentado, usando abordagens, questões e configurações diversas, nossas pesquisas sobre esse tópico indicam que nenhum pesquisador foi capaz de replicar as descobertas de Nyhan e Reifler.

Entre as muitas publicações dos parceiros da Avaaz, Dr. Ethan Porter e Dr. Tom Wood, está um influente artigo no qual eles criaram 52 cenários projetados especificamente para provocar o efeito contrário -- incluindo o cenário de Nyhan e Reifler sobre armas de destruição em massa no Iraque. O estudo de 10 mil pessoas nesses 52 cenários não produziu uma única ocasião em que o efeito contrário tenha ocorrido. Em 2019, Nyhan, Reifler, Porter e Wood, todos juntos, foram coautores de um artigo que finalmente derrubaria a teoria do efeito contrário.

Em primeiro lugar, as plataformas devem usar verificadores de fatos para “Mostrar os Fatos”, distribuindo correções de terceiros feitas de forma independente a cada indivíduo que viu as informações falsas. Os jornais publicam correções em suas próprias páginas, canais de televisão em sua própria programação: as plataformas de redes sociais devem fazer o mesmo em seus próprios canais.

1- Definir: a obrigação de mostrar os fatos e corrigir as fake news começaria quando:

Verificadores de fatos independentes constatassem que um conteúdo é falso ou enganoso;

Um número significativo de pessoas (por exemplo, 10 mil usuários) visualizasse o conteúdo.

2 - Detectar: as plataformas devem:

Usar, de forma proativa, tecnologias como inteligência artificial para detectar possíveis desinformações com potencial de alcance significativo, para que possam ser sinalizadas para os verificadores de fatos;

Disponibilizar um mecanismo acessível e visível para que os usuários relatem desinformações;

Fornecer acesso aos verificadores de fatos independentes a conteúdos que atinjam uma grande audiência (por exemplo, 10 mil pessoas ou mais).

3 - Verificar: as plataformas devem trabalhar com verificadores de fatos independentes e auditados por terceiros para determinar com precisão se o conteúdo relatado é desinformação.

4 - Alertar: cada usuário exposto à desinformação verificada deve ser notificado usando o padrão de notificação mais visível e eficaz da plataforma.

5 - Corrigir: cada usuário exposto à desinformação deve receber uma correção dos verificadores de fatos, tendo destaque, no mínimo, igual ao conteúdo original e seguindo as melhores práticas.

As plataformas online também devem, dentro de um um prazo razoável após receber um relatório de um verificador de fatos independente sobre desinformação com alcance significativo, tomar medidas para diminuir a sua propagação, como por exemplo reduzir o seu alcance nos feeds de notícias dos usuários.

Além disso, os governos e parlamentos devem legislar sobre a desinformação e exigir que o princípio de “Mostrar os Fatos” seja aplicado para informações falsas mal-intencionadas que possam ser prejudiciais.

A grande maioria das pessoas quer que o princípio de "Mostrar os Fatos" seja aplicado. Na Alemanha, França, Espanha e Itália, 87% das pessoas disseram que aprovam "Mostrar os Fatos". Ademais, 74% dos cidadãos do Reino Unido são a favor da idéia, assim como 68% de cidadãos nos EUA.

O mundo está pronto para legislar a desinformação. Para proteger seus cidadãos, governos sempre regulamentaram cada nova indústria na história moderna, até mesmo quando parecia impossível. Ferrovias. Rádio. Telefones. Televisão. Automóveis. Companhias aéreas. E em todos os casos, esses setores não apenas sobreviveram, mas prosperaram. Pelo bem da população, das democracias e do nosso planeta, chegou a hora de nossos líderes, mais uma vez, assumirem o comando e governarem os que aparentemente é ingovernável.

E não são apenas a Avaaz e os nossos membros que acreditam nisso -- 76% ou mais dos cidadãos da Alemanha, França, Espanha e Itália acham que as plataformas online devem ser regulamentadas. 81% dos cidadãos do Reino Unido concordam, assim como 61% dos americanos (apenas 18% dos entrevistados nos Estados Unidos é contra a regulamentação).

A União Européia soou o alarme sobre a desinformação. E o resto do mundo está começando a recuperar o tempo perdido. A ONU solicitou medidas para combater a ameaça global da desinformação. A Comissão Federal Eleitoral dos EUA recentemente convocou uma reunião política de alto nível para discutir a proteção das eleições nacionais. Parlamentares de todo o mundo uniram forças para desenvolver novas defesas para as suas democracias. O Congresso Brasileiro lançou uma grande investigação sobre desinformação nas eleições de 2018. França, Reino Unido, e Alemanha aprovaram ou estão desenvolvendo leis que regulamentam as redes sociais.

À medida que as evidências aumentam, e com esse estudo fornecendo provas claras de que as correções podem funcionar, instamos aos legisladores a criarem leis que tenham o princípio de “Mostrar os Fatos” em sua essência.

O Modelo: Factbook.org

Pergunta: se vocês não são o Facebook, como vocês sabem o quanto as correções funcionariam no ambiente do Facebook?

Resposta: nós construímos o nosso próprio Facebook.

Para se preparar para o estudo formal, a Avaaz passou meses construindo, testando e refinando um modelo que replica a aparência e usabilidade do Facebook. Investimos centenas de horas em desenvolvimento e testamos os resultados com milhares de membros da Avaaz na Europa e nos EUA. Conduzimos grupos focais sobre a experiência do usuário em Berlim e Nova York, com pessoas de vários países, para identificar e resolver problemas no design. O objetivo era criar uma ferramenta que oferecesse aos participantes do estudo formal uma experiência que fosse a mais próxima possível do Facebook real, em um ambiente de pesquisa. Uma demonstração do resultado, preenchida com as notícias falsas e as correções selecionadas para o estudo, pode ser encontrada em Factbook.org.5 [Todos os perfis no nosso modelo foram construídos usando nomes inventados e fotos de bancos de imagens. ]

Exemplo da interface do Factbook:

A Pesquisa: design

Para planejar o estudo formal, a Avaaz fez uma parceria com dois dos principais pesquisadores no campo da desinformação e correções: Dr. Ethan Porter, da George Washington University e Dr. Tom Wood, da Ohio State University.

Primeiro, escolhemos 5 notícias falsas presentes no Facebook e checadas por pelo menos dois verificadores de fatos independentes. Em seguida, criamos uma correção para cada uma dessas notícias falsas. As escolhas finais foram:

1. Trump acha que os Republicanos são "o grupo de eleitores mais estúpido do país.”

" />

" />

2. Os trabalhadores que instalam torres 5G precisam usar roupas especiais de proteção contra a radiação.

3. Foto mostra a deputada somali-americana Ilhan Omar em um campo de treinamento terrorista na Somália.

4. Greta Thunberg ganhou milhões com seu ativismo climático.

5. Surtos de sarampo nos EUA foram causados pela imigração ilegal.

A maioria dos usuários no mundo real verá correções algum tempo depois de ser exposta à desinformação original. Assim, dividimos o modelo em duas linhas do tempo. Na primeira, os participantes são expostos às notícias falsas (além de algumas postagens neutras, como fotos de comidas ou viagens). Na segunda, os participantes visualizam as correções, além de mais alguns itens neutros. Por fim, garantimos que o teste fosse totalmente aleatório. Especificamente:

Na primeira linha do tempo, os participantes viram entre zero e cinco itens falsos, além de três postagens neutras aleatórias. O número de itens falsos, quais itens (se houvessem) foram mostrados, e a ordem em que eles foram mostrados foi completamente aleatória.

Na segunda linha do tempo, os participantes viram correções correspondentes aos itens falsos aos quais foram expostos na primeira linha do tempo, além de três postagens neutras diferentes. O número de correções foi novamente gerado aleatoriamente, de zero até o número total de itens falsos visualizados na primeira linha do tempo.

Portanto, o design da pesquisa produziu, para cada pergunta do questionário, três grupos selecionados aleatoriamente:

Participantes que não viram nem o item falso nem a correção.

Participantes que viram o item falso, mas não a correção.

Participantes que viram tanto o item falso quanto a correção.

No final, foi solicitado a cada participante responder a um questionário, incluindo aqueles que não haviam sido expostos às notícias falsas. O questionário pedia para que eles classificassem afirmações que diziam respeito às informações falsas ou enganosas como: a) verdadeira; b) provavelmente verdadeira; c) provavelmente falsa; d) falsa; ou e) não tenho certeza:

Como as torres de 5G emitem radiação prejudicial, os trabalhadores que instalam os postes precisam usar roupas especiais de proteção contra a radiação.

Greta Thunberg é a ativista mais bem paga do mundo.

A deputada Ilhan Omar foi fotografada em um campo de treinamento da Al-Qaeda, na Somália.

Imigrantes ilegais causaram os recentes surtos de sarampo nos EUA.

Donald Trump chamou os Republicanos de "o grupo de eleitores mais estúpido" em uma entrevista à People Magazine, em 1998.

Os participantes foram recrutados e o estudo foi conduzido na plataforma de pesquisa acadêmica de alto padrão da YouGov. A YouGov descreve o seu método de amostragem e peso das respostas da seguinte maneira:

Os entrevistados foram comparados com um quadro de amostragem selecionando sexo, idade, raça e escolaridade. O quadro foi construído por amostragem estratificada a partir da amostra de um ano do Levantamento da Comunidade Americana (ACS) de 2016, com seleção dentro dos estratos por amostragem ponderada com substituições (usando as informações do respondente disponíveis no arquivo de uso público).

Os casos comparados foram ponderados com o quadro de amostragem usando escores de propensão. Os casos comparados e o quadro de amostragem foram combinados e uma regressão logística foi estimada para a inclusão no quadro. A função de escores de propensão incluía idade, sexo, raça/etnia, anos de estudo e região. Os escores de propensão foram agrupados em decis do escore de propensão estimada no quadro e posteriormente estratificados de acordo com esses decis.

Os pesos foram posteriormente estratificados na escolha do voto presidencial de 2016 e uma estratificação de quatro opções de gênero, idade (quatro categorias), raça (quatro categorias) e escolaridade (quatro categorias), para chegar ao peso final.

MOF não é um problema para a liberdade de expressão? Qual a diferença entre MOF e as "propostas de leis nocivas", a exemplo da Singapura?

MOF é vantajoso tanto para a democracia quanto para a liberdade de expressão: o conteúdo não é removido, mas simplesmente corrigido. Os fatos são adicionados, mas não se exclui as mentiras. Mecanismos de proteção também são necessários para resguardar a liberdade de expressão.

Essencialmente, a nossa proposta garante a existência de um método independente de verificação de fatos. Nós não acreditamos que, como aprovado pelo governo de Singapura, por exemplo, os governos devam ser os árbitros do que é verdadeiro e do que é falso. Ao invés disso, verificadores de fatos independentes, avaliados com base em padrões criteriosos, como os utilizados pela Rede Internacional de Verificação de Fatos, devem assumir essa responsabilidade. Os verificadores de fatos devem passar por revisão de pares regularmente para garantir que eles mantenham a sua independência. Os usuários também devem ter a possibilidade de requisitar uma revisão do conteúdo verificado se eles acreditarem que os verificadores de fatos erraram.

MOF também difere dos "projetos autoritários de lei", pois não propomos qualquer responsabilização criminal. Nossos princípios tratam os usuários das redes sociais como alvos e vítimas em potencial da desinformação, e nós pretendemos protegê-los.

MOF torna os governos e plataformas os árbitros da verdade?

Nem os governos nem as plataformas estariam envolvidos na decisão sobre um conteúdo ser desinformação ou não. É por isso que verificadores de fatos terceiros e independentes são uma parte tão importante para MOF.

E a sátira, o humor e as opiniões políticas legítimas?

Seguindo o Código de Prática Europeu, MOF isentaria a sátira, o humor e a opinião. Nenhum conteúdo seria excluído. Seriam corrigidos somente conteúdos virais e / ou deliberadamente falsos e enganosos, que possam causar danos à sociedade. Seriam corrigidos casos como: influenciar eleições por meio da supressão de eleitores, espalhar o ódio, semear maliciosamente a discórdia pública através de comportamento inautêntico coordenado ou causar uma crise de saúde pública.

A maioria dos conteúdos "falsos" não é falso, mas exagerado, sugestivo, generalizador, enganoso ou manipulador. Como as correções funcionariam nesses casos?

As correções devem buscar remediar o dano causado, portanto devem ser proporcionais e focadas exatamente no que há de errado com o conteúdo. Os verificadores profissionais de fatos são especialistas em definir exatamente o que há de errado com um conteúdo específico. Ele é totalmente falso? Ele usa a verdade, mas a distorce fora de contexto? Ele usa uma imagem falsa, ou usa uma imagem real que não tem nenhuma relação com o conteúdo? Ele tem como objetivo perpetuar a crença em mentiras já desmascaradas? Esses padrões já existem e estão sendo constantemente refinados por verificadores de fatos em todo o mundo. O que queremos são alertas sofisticados e verificações de fatos que não apenas informem aos usuários que um conteúdo é falso, mas que também os ajudem a entender por que ele é falso.

A desinformação está em uma trajetória descendente.

As plataformas que fazem essa afirmação não forneceram dados que comprovem isso. A falta de transparência é notória. Pesquisas da Avaaz mostram que processos eleitorais democráticos ainda estão sendo inundados com desinformação (por exemplo, consulte os nossos relatórios (em inglês) “Redes enganosas da extrema direita” e “EUA 2020: Outra eleição de desinformação do Facebook?”). Da mesma forma, a escala e o alcance das plataformas de redes sociais são tão significativos que mesmo a desinformação direcionada a milhares de usuários pode ter um impacto significativo nos resultados de eleições. E, mais importante, acreditamos que MOF desencorajaria os agentes da desinformação e ajudaria a garantir que ela realmente entre em trajetória descendente.

As plataformas já estão tomando medidas contra a desinformação. Por que MOF é tão importante?

MOF é a única solução que combate os efeitos da desinformação que já foi compartilhada. Capturar a desinformação antes dela circular é o ideal, mas esse sistema nunca será perfeito.

A prevenção é importante, mas também precisamos de tratamento. Educação e resiliência são cruciais, mas requerem um tempo que não temos. A Avaaz documentou redes de desinformação da extrema direita que alcançaram 750 milhões de visualizações em três meses antes das eleições europeias, em maio de 2019. A nossa pesquisa se concentrou apenas em seis países, indicando que tais resultados foram apenas a ponta do iceberg. Até o momento, milhões de pessoas que as viram não sabem que foram enganadas. Somente MOF pode resolver esse problema.

As plataformas já estão exibindo correções e/ou alertas. Elas já não estão aplicando MOF?

O fato de o Facebook e outras plataformas implementarem versões limitadas da medida MOF em alguns mercados e/ou a respeito de tópicos específicos (como na desinformação antivacina) mostra que MOF é tecnicamente viável e eficaz. No entanto, para fazer frente realmente à ameaça de desinformação, essas correções precisam ser mostradas a todos que forem expostos às informações falsas e não apenas a alguém que, por exemplo, comenta ou compartilha a notícia falsa após o conteúdo ter sido verificado. Isso não tem acontecido atualmente e, como resultado, a grande maioria das pessoas expostas às notícias falsas nunca verá uma correção.

Não existem verificadores de fatos suficientes para mostrarem os fatos.

A Avaaz conversou com algumas das organizações de verificação de fatos mais citadas e mais proeminentes do mundo, e elas garantem que o setor pode crescer rapidamente. Quando MOF criar demanda, o setor de verificação de fatos crescerá. Grandes doadores e filantropos provavelmente estão prontos para apoiar esses esforços em grande escala. Além disso, à medida que as fontes de verificação de fatos forem divulgadas via MOF, suas páginas receberão mais visitantes e publicidade, o que pode garantir aumento das suas fontes de renda.

Além disso, outras ferramentas de financiamento coletivo para a verificação de fatos estão atualmente sendo testadas pela Wikipedia e pelo Twitter, e podem oferecer soluções baseadas na colaboração de comunidades online.

Ademais, existe uma ampla gama de tópicos de desinformação, como o movimento antivacinação, o negacionismo climático, a desinformação russa disseminada pela Agência de Investigação da Internet e outras, onde uma ou duas correções simples podem ser aplicadas milhões de vezes em milhões de postagens. Além disso, em momentos eleitorais urgentes, por exemplo, quando a desinformação é disseminada apenas alguns dias antes da votação, os verificadores de fatos costumam ser rápidos em divulgar correções. E nesses momentos críticos, é essencial garantir que essas correções atinjam milhões de pessoas.

Por fim, não devemos olhar apenas para os recursos já existentes para a verificação de fatos e afirmar que uma verificação em maior escala não funcionaria. Ao invés disso, assim como essas plataformas passaram de poucos usuários a bilhões de pessoas em todo o mundo, acreditamos que a verificação de fatos pode ser expandida e se tornar mais eficaz através de soluções inovadoras.

As correções não funcionam e podem ter efeito contrário.

Vários Estudos Revisados Por Pares demonstraram que correções eficazes podem reduzir, e até mesmo eliminar, os efeitos da desinformação. Estudos que tentam replicar o frequentemente discutido "efeito contrário" (ou seja, quando correções aprofundaram ainda mais falsas crenças) chegaram à conclusão oposta. Enquanto isso, pesquisadores estão reunindo as melhores práticas para correções eficazes.

As correções eficazes devem salientar os fatos (evitar a repetição do mito), conter um contra-argumento simples e breve e estar alinhado à identidade e a visão de mundo dos usuários de redes sociais que receberem cada correção.

Provavelmente sempre haverá uma pequena minoria de ideólogos que defendem tópicos como a antivacinação, o terraplanismo ou a supremacia branca. Mas essa pequena minoria não é o público-alvo da proposta de "Mostrar os Fatos". Queremos chegar à grande maioria dos usuários que não são ideólogos, mas são inundados por conteúdos de desinformação destinados a recrutá-los para essas teorias da conspiração. São essas pessoas as que mais se beneficiariam com a MOF, e que podem ser vacinadas contra as tentativas de desinformá-las.

Em 2019, Nyhan, Reifler (os autores do tão citado artigo sobre o "efeito contrário"), junto com nossos parceiros de pesquisa, Porter e Wood, escreveram um artigo que finalmente derruba a tese do efeito contrário.

As notícias falsas são mais antigas que as redes sociais. Elas sempre existiram e sempre vão existir.

Não estamos enfrentando um problema novo. Mas esse problema antigo agora encontrou um novo terreno, onde consegue rapidamente ter um enorme alcance -- e, portanto, um impacto muito maior.

Pesquisas, incluindo estudos do MIT, descobriram que as notícias falsas são amplificadas nas redes sociais e podem se espalhar rapidamente. Além disso, as nossas sociedades desenvolveram soluções contra antigas formas de desinformação, mas atores mal-intencionados descobriram que as redes sociais são um terreno fértil que pode ser usado para contornar essas soluções. Além do mais, as plataformas de redes sociais fornecem uma aura de segurança que incentiva os usuários à interações e à revolta, o que os torna muito mais vulneráveis às táticas de guerra informacional. Por isso, é central que plataformas e governos aumentem as proteções com a implementação de correções.

Para saber mais: envie um e-mail para nosso time de mídia em: media@avaaz.org

Notas finais

Compartilhe nas redes